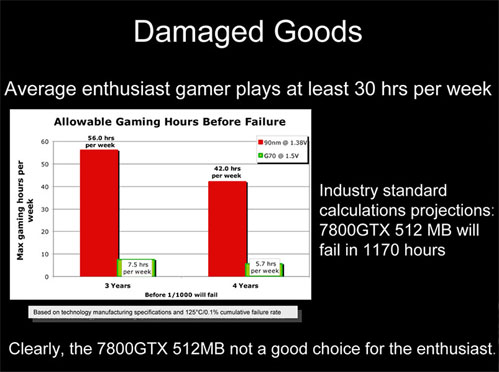

The Inquirer, nooit afkerig van een gerucht hier en een knuppel in een hoenderhok daar, heeft ATi uitgedaagd vanwege een recent verschenen interne presentatie van het bedrijf. In de presentatie claimt ATi dat nVidia’s 7800 GTX met 512MB geheugen alleen sneller is dan de ATi X1800XT vanwege buitenproportionele opvoering van het voltage waarop de gpu van nVidia zijn werk doet. Op basis daarvan claimt ATi daarom dat een 7800 GTX slechts 1170 levensuren heeft voor het spelen van games. Omgerekend zou dit bij een gebruiksduur van drie jaar neerkomen op 7,5 uur gamen per week. Als een gamer de kaart vier jaar wil gebruiken, dan zou hij zelfs maar 5,7 uur per week met de kaart spellen mogen spelen. De X1800XT kan volgens ATi, niet geheel verrassend, 56 uur per week intensief belast worden als de kaart drie jaar mee moet; bij een levensduur van vier jaar mag een gamer de kaart 42 uur per week gebruiken. The Inquirer gelooft dit niet en heeft daarom zowel nVidia als ATi gevraagd om respectievelijk een 7800 GTX 512MB en een X1800XT te leveren. De fabrikanten mogen zelf weten of ze alleen de kaart of een volledig systeem aanleveren. De kaarten zullen vervolgens 1170 uur, 11 minuten en 7 seconden met 100% gpu-belasting aan het werk worden gezet. De maker van een overlevende kaart krijgt van The Inquirer een T-shirt met daarop de melding ‘I Survived the 1170 Hour 11 Min 7 Sec Marathon’.