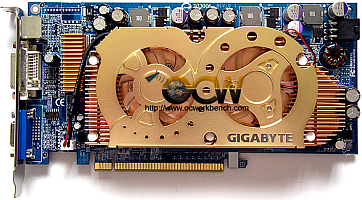

De jongens van OC Workbench wisten een Dual nVidia 6600GT, waarover we onlangs nog schreven, te bemachtigen voor enkele benchmarks. De Gigabyte-kaart draagt de naam 3D1 en beschikt over 256MB GDDR3-geheugen en een 256bit-geheugenbus met twee gpu's op één kaart. Deze SLI-opstelling zonder twee kaarten te moeten installeren biedt als belangrijkste voordeel de verminderde latency die zou moeten optreden. De cores zijn beiden geklokt op 500MHz en het geheugen doet zijn werk op 560MHz. Met deze specificaties biedt de kaart dan ook veelbelovende perspectieven voor optimale prestaties. Nadat de kaart uitgebreid bestudeerd en ontleed werd, was het tijd om ze te installeren en enkele benchmarks voor te schotelen.

Het testsysteem bestond daarbij uit een AMD Athlon FX-53 op 2,4GHz op een Gigabyte K8NXP-SLI uitgerust met 1GB geheugen. De eerste benchmark die aan bod komt is 3DMark2001SE, maar daarmee blijkt de kaart slechts 2200 punten prestatiewinst op te leveren in vergelijking met een GV-NX66T128D-3. In 3DMark03 zien we de score echter bijna verdubbelen tot 14.478 punten met driverversie 71.24. De drivers met volgnummer 66.93 scoren, net zoals in de vorige test, iets minder. Ook in 3DMark2005 herhaalt dit fenomeen zich, maar met Comanche 4 is de dual-core kaart zelfs iets trager dan de NX66T128D. In Doom 3 zijn de resultaten enigszins verdeeld, afhankelijk van de instellingen, maar met 8xAA en 16xAF scoort de dual-core videokaart 41,5fps, in verhouding tot 103fps zonder AA of AF. De NX66T128D-3 haalt hier 79,1fps.

Na nog een laatste test met Aquamark 3, waarin de 3D1 het ook iets beter doet, gaat de reviewer over tot zijn conclusie. Volgens de reviewer scoort deze kaart steeds een paar procent beter dan twee losse 6600GT-kaarten in SLI-mode. Als sterkste punten haalt hij dan ook de uitstekende prestaties, stabiele werking en de warmteontwikkeling die binnen de perken blijft aan. Jammergenoeg is de 3D1 geen uitstekende overklokker, aldus de reviewer, maar desondanks toch een uitstekende keuze, vooral als Gigabyte zijn claim waar maakt en deze kaart goedkoper zal zijn dan twee aparte SLI-videokaarten.

:strip_exif()/i/1101429863.jpg?f=fpa)