Bij Spectrum Online is een uitgebreid verhaal verschenen over Turbo-code; de manier om meer gegevens foutloos door een zendkanaal te persen. Ruim een halve eeuw geleden toonde Shannon aan dat het in theorie mogelijk is om data foutloos door een kanaal te verzenden met een snelheid praktisch gelijk aan de maximale theoretische bandbreedte. Het bleek echter lastig om deze snelheid te halen aangezien hiervoor met de huidige codeer- en decodeertechnieken een astronomische hoeveelheid rekenkracht nodig is. Hierdoor bleef het verschil tussen de praktijk en de theorie, in decibels uitgedrukt, rond de 3,5dB. Met behulp van Turbo-code kan dit gat flink verkleind worden tot slechts 0,5dB met een bit-error rate van één op honderdduizend.

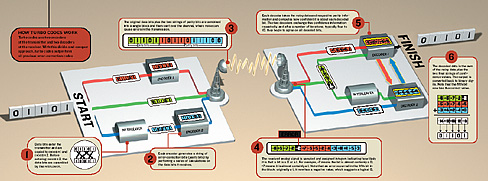

De werking van Turbo-codes is te complex om hier beknopt uit te leggen. Daarom zullen we alleen kort aanwijzen welke eigenschappen de Turbo-codes zijn kracht geven ten opzichte van klassieke coderingsmechanismen. De kracht van de Turbo-code zit in het feit dat de data tweemaal gecodeerd wordt en ook tweemaal gedecodeerd. De verschillende decoders converteren de analoge data niet alleen naar simpelweg nul en één, maar geven ook aan hoe waarschijnlijk het is dat dit correct is. Dankzij deze informatie en de gegevens van de tweede decoder kan de eerste decoder met relatief weinig rekenwerk foutgecorrigeerde gegevens ontvangen. Momenteel wordt gewerkt om Turbo-codes te gebruiken in verschillende apparaten. Onder andere de Mars Reconnaissance Orbiter and Messenger van de NASA zal gebruik maken van Turbo-code voor de communicatie. Dichter bij huis zullen de nieuwste generatie telefoons er ook gebruik van maken.