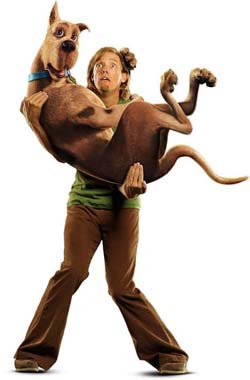

ik heb stukken van de film gezien maar ik moet zeggen dat ik de scooby doo er erg nep uit vind zien

dacht dat ze met de huidige computertechniek toch wel zo ver waren dat hij er iets realistischer uit zou zien

misschien ben ik wel verwend maar ik vond em er erg gemaakt en misschien wel afgeraffeld uitzien

hhhmmm, beetje film gebruiken ze render boxen voor, en inderdaad de hond ziet er niet overtuigend uit, dit had veel beter gekunt, kijk maar naar final fantasie bijv

Net als eerder al gezegd is, het is de bedoeling geweest om scooby-doo er cartoony uit te laten zien, je hebt alles te danken aan de (art)-director. Final Fantasy is wat dat betreft een slecht voorbeeld, hoewel het 'realiteits-gehalte' allicht hoger was, was ook hier sprake van een tussenvorm (cartoon/niet-van-echt-te-onderscheiden). Overigens is FF geflopt, dus realiteit moet niet vanzelfsprekend het uitgangspunt zijn.

Maar het klopt verder wel dat je kunt zien wanneer iets met de computer gemaakt is.

Dit was ook in blade 2 het geval (gevecht tussen blade en de vrouwelijke vampier).

Wat mij opvalt als je computer animatie's ziet is dat ze zo'n rare glimmende gloed over zich heen hebben.

En als het om bewegende beelden gaat (zoals in blade 2) maken de computer animatie's zo'n rare krommende beweging als ze landen op de grond. Dit was ook te zien in starwars episode I waar dark morth (hoe schrijf je dat?) van zijn vliegende motor thingie afspring en land voor die ene jedi en gaat vechten.

Hetzelfde geldt voor Blade 2, ook gebasseerd op een cartoon. In Blade 2 zijn de characters met opzet 'cartoony' geanimeerd.

Geloof me, 50% van de tijd kun je niet eens zien dat er gebruik gemaakt is van CG effecten, er valt namelijk weinig eer te behalen aan camera's wegpoetsen, en muurtjes opnieuw 'stuken'

Als iets er CGI uitziet, terwijl het er realistisch uit hoor te zien (glimmen bijv.) geef dan de texture-artist/belichter/compositor de schuld.

weet iemand of men nu ook al nieuwe technieken zoals global illemunation / final gathering etc over de 3d modellen gepleurd?! of ziet het er nog steeds zo cartoonie achtig uit (like monster inc etc (pixar))..

global illumination is veel te reken intensief voor feature films, er is domweg geen tijd/geld voor, je kunt ook leren zelf te belichten. het gebruik van GI is nog zeer beperkt.

De kwaliteit van het eindproduct hangt af van de software waar het mee gecreeert wordt

De kwaliteit hangt in beperkte mate af van de software, het zijn de modellers/animators/text.painters/compositors/belichters/etc. die de film maken.

Iedereen kan knoppen drukken.

nee, dat hebben we te danken aan 3dStudioMax met een paar van die mooie plugins waarmee je 1 object kunt vermenigvuldigen en onafhankelijk van elkaar kunt aansturen (voor't eerst toegepast in Jurassic Park

Dat hebben we dus niet te danken aan 3DSMax, laat staan in Jurassic Park, dat was vooral Softimage.

In EPII is veel gebruik gemaakt van 2D compositing, vooral met die clones, en dan is er nog die custom-software die ze bij ILM schrijven.

Het gebruik van 3DSmax in film is minimaal.