Één van de in technisch opzicht interessantere films van dit jaar, is ongetwijfeld Final Fantasy: The Spirits Within. De op een populaire serie computergames gebaseerde CG animatie, legt de lat opnieuw hoger binnen haar genre, als het gaat om visueel realisme. Zo zeer zelfs, dat sommige acteurs vrezen in de toekomst werkloos te worden door producties met digitale acteurs. Soortgelijke bezwaren waren vroeger ookal te horen geweest, bij de introductie van technieken als geluid, kleur en blue-screens in de filmwereld. De mogelijkheden lijken bij iedere volgende animatiefilm weer vergroot te zijn. Net als iedere nieuwe technologische ontwikkeling, kan deze ten goede en ten kwade gebruikt worden.

|

Dat de totstandkoming van FF een technologisch en logistiek hoogstandje is, wordt duidelijk als je het interview leest, dat Ars Technica hield met een aantal makers van de film. Bij de productie waren uiteenlopende professionals betrokken, zoals 2D & 3D artiesten, schrijvers, programmeurs, managers, sysadmins en vele andere met diverse achtergronden. Om het ingewikkeld te maken waren ze ook nog eens afkomstig uit meer dan 20 verschillende landen en spraken velen een andere taal, waardoor de inzet van tolken vereist werd. Wat hardware betreft: er werd gebruik gemaakt van vier SGI 2000 series servers, vier Silicon Graphics Onyx2 visualisatie systemen, 167 (honderd-zeven-en-zestig) Silicon Graphics Octane visual workstations en andere SGI systemen. De belangrijkste software die toegepast werd was Alias|Wavefront Maya voor het modelleren en animeren op de SGI machines en het renderen werd hoofdzakelijk gedaan met Pixar's Renderman, draaiend op systemen met Linux O.S (Red Hat 6.2).

Ter vergelijking: een frame in een game-scene bestaat gemiddeld uit zo'n 6000 polygons. In het geval van Final Fantasy ligt dat nét even anders

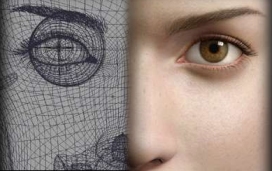

Ter vergelijking: een frame in een game-scene bestaat gemiddeld uit zo'n 6000 polygons. In het geval van Final Fantasy ligt dat nét even anders ![]() . Characters die niet close-up in beeld komen zijn opgebouwd uit zo'n 100k polygons. Main characters die vol in beeld komen kennen een hogere poly-count: 300k voor kleding, 30k voor gezichtsgeometrie, 20k voor gezichtsbeharing zoals wenkbrauwen en wimpers en 60k voor hoofdhaar. Even afgezien van test renders, revisies en reviews, zouden de final renders 934.162 dagen rendertijd in beslag hebben genomen op één processor. Gelukkig had men een renderfarm ter beschikking van ongeveer 1.200 processoren (Pentium III, custom built, rackmounted). Dus nog heel eventjes geduld, voordat je een videokaart kunt gaan halen die dit soort animaties realtime op je monitor neergooit

. Characters die niet close-up in beeld komen zijn opgebouwd uit zo'n 100k polygons. Main characters die vol in beeld komen kennen een hogere poly-count: 300k voor kleding, 30k voor gezichtsgeometrie, 20k voor gezichtsbeharing zoals wenkbrauwen en wimpers en 60k voor hoofdhaar. Even afgezien van test renders, revisies en reviews, zouden de final renders 934.162 dagen rendertijd in beslag hebben genomen op één processor. Gelukkig had men een renderfarm ter beschikking van ongeveer 1.200 processoren (Pentium III, custom built, rackmounted). Dus nog heel eventjes geduld, voordat je een videokaart kunt gaan halen die dit soort animaties realtime op je monitor neergooit ![]() .

.

De vraag is of het publiek liever naar acteurs kijkt van vlees en bloed. In principe zou het mogelijk zijn, om niet alleen fictieve characters, maar ook bestaande of inmiddels overleden beroemdheden digitaal te 'klonen' en op het scherm tot leven te wekken. Dat laatste zal wel de nodige juridische problemen geven omtrent persoonlijkheidsrechten en dergelijke. Feitelijk krijgen de animators de rol van de acteur toebedeeld. Zij moeten door het manipuleren van houding, gezichtsuitdrukkingen, de bewegingen van de character en diens haar en kleding, ervoor zorgen dat de digitale marionet tot leven wordt gewekt. In een cartooneske animatie als SHREK lukte dat vrij aardig. Maar wanneer de realiteit benaderd wordt, is dat een stuk lastiger, omdat de characters dan met echte mensen vergeleken worden en wij nu eenmaal een zeer goed geoefend oog hebben in het ontwaren van details en nuances in gezichtsuitdukkingen. Of een film goed is of niet, draait uiteindelijk om de vraag; is het een goed verhaal dat op een boeiende manier verteld wordt? Vanaf 16 augustus kun je in Nederlandse bioscopen zelf gaan beoordelen of dit met Final Fantasy het geval is.

br>

jeroen, bedankt voor de link!