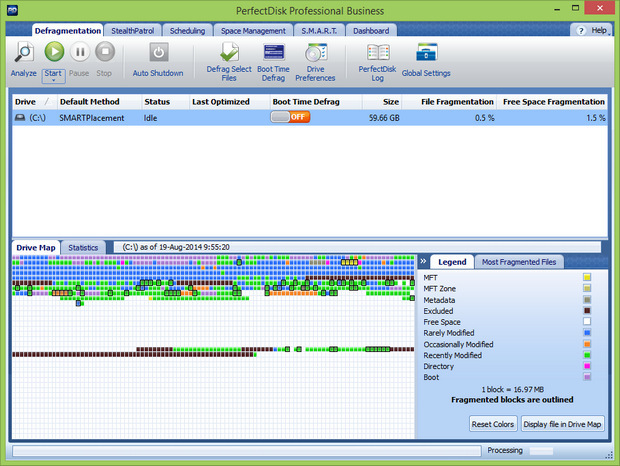

Raxco Software heeft service pack 4 voor versie 13.0 van zijn defragmenteerprogramma PerfectDisk uitgebracht. Dit programma reorganiseert de locatie en volgorde van de bestanden op de harde schijf, zodat deze sneller te benaderen zijn. Dit resulteert in het sneller starten van programma's en het sneller booten van de pc. PerfectDisk is geschikt voor Windows XP en hoger, voor zowel de 32bit- als de 64bit-varianten. Een evaluatieversie kan op deze pagina worden gedownload. Prijzen beginnen bij dertig dollar voor een enkele thuislicentie. In deze release zijn de volgende veranderingen en verbeteringen aangebracht:

Raxco Software heeft service pack 4 voor versie 13.0 van zijn defragmenteerprogramma PerfectDisk uitgebracht. Dit programma reorganiseert de locatie en volgorde van de bestanden op de harde schijf, zodat deze sneller te benaderen zijn. Dit resulteert in het sneller starten van programma's en het sneller booten van de pc. PerfectDisk is geschikt voor Windows XP en hoger, voor zowel de 32bit- als de 64bit-varianten. Een evaluatieversie kan op deze pagina worden gedownload. Prijzen beginnen bij dertig dollar voor een enkele thuislicentie. In deze release zijn de volgende veranderingen en verbeteringen aangebracht:

What’s new in PerfectDisk 13 Service Pack 4 (Build 843)

- Added the ability to detect files that are approaching the NTFS File Attribute List max size of 256KB and exclude them from defragmentation operations. Files that exceed this limit can not create additional file fragments - resulting in application or other errors. Note that this limit has nothing to do with the actual size of a file. This limit has to do with how badly fragmented the file is. If a file is badly fragmented and is approaching this limit, defragmenting the file could push it over the limit.

For more information, please see this blog post.- Log Viewer sorting issue fixed.

- Changes made for PerfectDisk for vSphere to work with vSphere 6.0.

:fill(white):strip_exif()/i/2000538333.jpeg?f=thumbmedium)