Voor een snelle verwerking van newserver downloads moet je een goed geconfigureerde PC hebben.

Newsleecher haalt alle data als kleine hex encoded articles binnen en die worden op disk (tijdelijk) gezet en dan gedecodeerd naar binaire bestanden (vaak .rar). 1 rar kan wel 100-en articles zijn. dat genereerd gigantisch veel disk I/O.

Als alles klaar is worden al die bestanden middels PAR gecontroleerd en eventueel gerepareerd, dat is ook enorm veel disk I/O.

Als dat klaar is moet het nog geaxtract worden dat is wederom veel disk I/O.

Nadat ik dat goed door had heb ik een systsem geprpareerd op NewsLeecher en haal ik nu met gemak 26MByte/sec download. dat door 3 newservers te gebruiken over 3 internet lijnen gecombineerd is zijn die ook zo'n 240Mbit/sec.

Kortom, een lokale news client om te downloaden gebruikt veel disk I/O en daar zit dan ook jullie bottleneck.

NewsLeecher kan trouwens best efficienter gemaakt worden. Downloaden van articles doet hij met vele treads tegelijk per newserver pakt ie een aantal connecties (vaak zo'n 10 per server). Dat gaat goed,

Maar het decoderen, repareren en extracten gaat middels maar 1 tread en die houd vaak alles op.

Als dat in meerdere treads over een multicore verdeeld word zou alles veel sneller gaan.

[Reactie gewijzigd door t-force op 25 juli 2024 01:39]

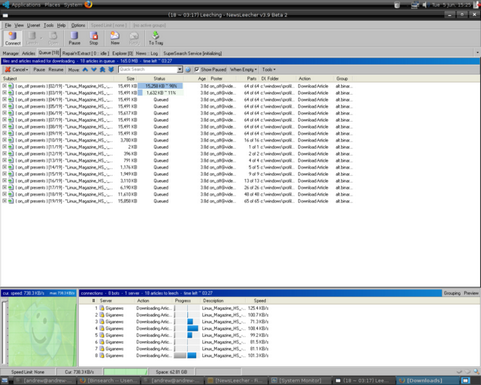

NewsLeecher is begonnen met de ontwikkeling van versie 5.0 en onlangs is de eerste bètarelease verschenen. Met dit programma is het mogelijk om op een eenvoudige manier bestanden uit nieuwsgroepen te downloaden. Het programma ondersteunt nzb-bestanden, beschikt over een zogeheten SuperSearch, en kan gedownloade bestanden automatisch op integriteit en volledigheid controleren, en vervolgens zelfstandig uitpakken. Nieuw in versie 5.0 is dat er tabs zijn toegevoegd aan de SuperSearch.

NewsLeecher is begonnen met de ontwikkeling van versie 5.0 en onlangs is de eerste bètarelease verschenen. Met dit programma is het mogelijk om op een eenvoudige manier bestanden uit nieuwsgroepen te downloaden. Het programma ondersteunt nzb-bestanden, beschikt over een zogeheten SuperSearch, en kan gedownloade bestanden automatisch op integriteit en volledigheid controleren, en vervolgens zelfstandig uitpakken. Nieuw in versie 5.0 is dat er tabs zijn toegevoegd aan de SuperSearch.

:fill(white):strip_exif()/i/1387547125.jpeg?f=thumbmedium)