OMG, wat een slap verhaal.. ongelofelijk, iedereen ziet een lap tekst en zegt dan, hey laat ik m maar s 2 pluspuntjes geven.

Maar dit verhaal is, zonder harde bewijzen, m.i. volledig uit de grote duim gezogen.

Ik kan b.v. het zelfde verhaal van hierboven neertypen, alleen wissel ik dan AMD en Nvidia om, en tadaa, ineens lijken de Nvidia kaarten slechter. Wat een hoop gezwets.

U vraagt om een onderbouwing? Komt ie dan he!

Je kan ook duidelijk aan de elektronica op de kaarten zien dat ATi extreem complexe kaarten moet maken om in de buurt van een nvidia kaart te komen die relatief eenvoudig is opgebouwd. Dit boeit de consument niet, maar laat wel problemen zien op technisch vlak wat ik dan toch wel interessant vind om te constateren.

Hmpff! Was ik de enige die hier om moest lachen? De man kijkt naar 2 kaartjes en ziet duidelijk dat de AMD kaart veel moeilijker tot stand is gekomen dan de Nvidia kaart? Juist...

Dit betekent ook dat ze veel meer verlies zullen leiden op hun producten. Mij zal het niets verbazen als de huidige ATi's op productiegebied meer kosten dan nVidia kaarten en ze kunnen er minder voor vragen omdat ze voordeliger moeten zijn dan nVidia. Dit werkt erg in hun nadeel.

Hoppa, 1 - ik zuig uit mijn duim dat AMD kaarten moeilijk te maken zijn

2 - Daarna verzin ik gewoon dat AMD kaarten dan maar duurder moeten zijn! Als mensen in mijn eerste uit de duimzuig verhaal geloven, slikken ze dit ook wel.

en idd! ze geloven het ook nog

Ook had je kunnen zeggen dat de nieuwe GPU van b.v. een HD3870 verkleind is wat als voordelen met zich meebrengt: Goedkoper om te fabriceren - minder stroomverbruik (en dus ook minder warmteontwikkeling) - betere prestaties. Maar goed...

Een duidelijk voorbeeld haalde ik uit mijn onderzoek naar de snelste AGP kaartjes vorig jaar. Een Geforce 7800GS en een Radeon X1950PRO. De kaarten presteren ruwweg gelijk aan elkaar, maar er zitten nogal wat haken en ogen aan de ATi kaart.

Ten eerste, ik strip de kaarten helemaal kaal. Dan zie je dat ATI's kaart extreem complex is en nVidia's kaartje lijkt wel een budget-geval. Daarnaast verbruikt de ATI kaart meer vermogen en wordt daardoor veel warmer. De ATi kaart valt voor geen meter over te clocken wat laat zien hoe ze erg tegen de grens van de GPU aanzitten (dat doen ze nu overigens nogsteeds, laat zien hoe ze de boel moeten pushen om in de buurt van nVidia te komen), eigenlijk niet eens geoorloofd om zoiets op de markt te brengen want het kan erg onstabiel zijn en er waren ook nogal wat uitval exemplaren van deze kaart. nVidia's Core kon van 380MHz zonder moeite op 500MHz gezet worden (met voltmod nu op 700MHz). Daarnaast is de grootste tegenvaller dat ATi's kaart er op papier een stuk beter uitkomt, maar dit niet waar kan maken.

AGP? Wtf test je nog ouwe AGP meuk voor dan? Hallooooo, PCI Express? En je hebt toch wel gelezen dat de HD 38XX serie zich zeer goed leent voor overclocken? Nee laten we het eens over ouwe troep van vorig jaar hebben voor een slot waar praktisch geen kaart voor gemaakt word! Waarom haal je in godsnaam oude feiten aan in de review van een nieuwe kaart? Waarschijnlijk alleen omdat je je gelijk wil halen, maar doe dat dan met vergelijkbare nieuwe kaarten.

Ik sla daarna even een hele stuk onzin over die ik niet eens de moeite waard vind om hier te noemen. Helaas zal ik toch even iets moeten zeggen, anders krijg ik daar weer gezeur over.

Als AMD kaarten zo haperen, dan werden ze echt niet verkocht. Zelf heb ik ook wel eens haperingen flikkeringen en weet ik veel wat gehad met mijn videokaart, maar na een driverupdate was dit opgelost, voor zowel AMD als Nvidia kaarten. Maar om nu maar te gaan zeggen dat een AMD videokaart altijd hapert en een Nvidia kaart niet, vind ik lulkoek. Ja, misschien dat jou AMD kaart last had van die problemen, maar dat je het ineens moet generaliseren op alle AMD kaarten is dan toch weer een beetje teveel van het goede of niet?

Dit laatste stukje doe ik niet met plezier! Mensen die zichzelf voor paal zetten hebben het al moeilijk genoeg. Ik wrijf het niet graag in maar vooruit, je vraagt er wel om.

Wat ik hier verder aan toe wil voegen is dat ik beide fabrikanten omarm en niets de grond in wil trappen maar een zo duidelijk mogelijk beeld wil schetsen voor mezelf wat momenteel de verschillen zijn. Het hele onderzoek heb ik spijtig genoeg (hoe egoistisch ik dan mag zijn) puur voor mezelf gehouden. Een artikel was leuker voor jullie geweest, maar zoals zovaak zijn er een hoop fanboys die hoe dan ook toch hun eigen weg kiezen, net zoals ik zo eigenwijs ben om altijd MIJN eigen weg te kiezen en alles zelf uit te willen zoeken. Ik kan alleen maar aanraden om een nVidia kaart te nemen, meer niet.

Ja, dus je wilt weten wat momenteel de verschillen zijn, en dat test je met oude AGP kaarten? Ahum...

Bovendien geef je zelf al aan een eigenwijze flikker te zijn, en ik denk dat dat ongeveer het enige is waar ik je gelijk in kan geven.

En deze X2, tjah gewoon een veel te lomp overdreven ding die onder de maat presteert. Kwa prijs kan de kaart wel meekomen met nVidia en is het de overweging misschien waard, maar puur vanuit technisch oogpunt is hij waardeloos. Jammer, ik hoop nog eens op zo'n comeback zoals met de R300. Nou weer genoeg gelult

Overal word de kaart met veel lof binnengehaald, maar meneer de AGP testexpert weet het weer beter. Deze kaart levert gelijkwaardige prestaties aan een 8800 GTX, is zelfs nog beter in coderen van HD, kost veel minder dan een 8800 Ultra en kan gebruikt worden voot quadCF, maar hij vind het niks!

Zucht, en dat hele onzinverhaal, zonder onderbouwing, zonder ook maar een kleine beargumentatie (behalve dan dat jij het ziet) word ook nog eens goed geloofd door de makke schaapjes die niet verder kijken dan hun neus lang is.

Ik hoop dat men wat kritischer naar dit soort onzin gaat kijken, want door dit soort ellendige verhaaltjes komen veel misverstanden de wereld in.

[Reactie gewijzigd door Verwijderd op 22 juli 2024 14:10]

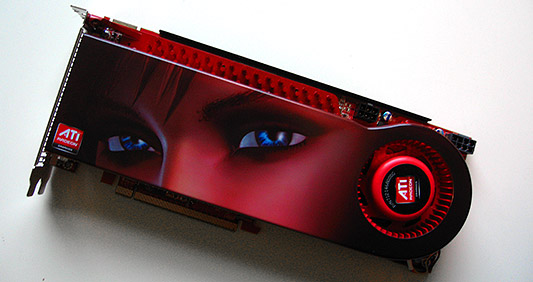

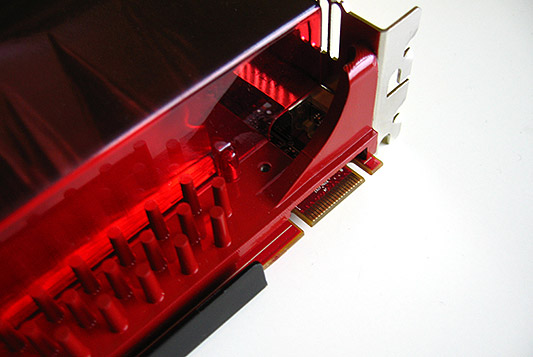

AMD heeft vandaag de Radeon HD 3870 X2 geïntroduceerd. Deze videokaart bevat twee gpu’s en is AMD’s poging om weer een voet aan de grond te krijgen in de high-end videokaartenmarkt. In deze review kijken we hoe succesvol deze poging is en zetten we de kaart onder andere tegenover de GeForce 8800 Ultra.

AMD heeft vandaag de Radeon HD 3870 X2 geïntroduceerd. Deze videokaart bevat twee gpu’s en is AMD’s poging om weer een voet aan de grond te krijgen in de high-end videokaartenmarkt. In deze review kijken we hoe succesvol deze poging is en zetten we de kaart onder andere tegenover de GeForce 8800 Ultra. De kaart

De kaart

:fill(white):strip_exif()/i/2000783144.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783414.jpeg?f=thumbmedium)

:strip_exif()/i/1195224118.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783707.jpeg?f=thumbmedium)

:strip_icc():strip_exif()/u/100224/paladin-small.jpg?f=community)

:fill(white):strip_exif()/i/1195225803.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783620.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783418.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783182.jpeg?f=thumbmedium)