Problemen met de servers en de netwerkverbinding van Tweakers.net worden in deze .plan gemeld. De laatste informatie over de serverloads en -uptimes kun je volgen op de Statusmeldingen

Na enig zoekwerk kwamen we erachter dat we last hebben van deze bug. Om last van deze bug te hebben moet je aan een aantal randvoorwaarden voldoen, meer dan 4GB geheugen: check, 64bits kernel: check. Adaptec raid: check.

Oftewel: die raidcontroller loopt te bokken. En vandaag wat erger dan gisteren, want vandaag kapte 'ie er helemaal mee. Er staan in de bugreport wel een aantal semi oplossingen die we op dit moment achter de schermen aan het bespreken zijn om te zien welke oplossing ons probleem op zal lossen.

Update 15:39: We bennuh klaor, en we gaon naar huus.

Update 14:31 Blijkbaar is er iets mis met de nieuwe loadbalancers, dus as we speak racet Daniel naar Redbus toe om daar een oude loadbalancer weer aan te zetten zodat dit knipperlicht gedoe hopelijk over is

Update 14:58 Inmiddels is een van de oude loadbalancers in Redbus zo vriendelijk geweest (met wat hulp van Daniel

procs -----------memory---------- ---swap-- -----io---- -system-- ----cpu----

r b swpd free buff cache si so bi bo in cs us sy id wa

2 0 0 442524 4704 21740 0 0 0 0 18173 14 0 99 1 0

0 0 0 442524 4704 21740 0 0 0 0 18566 37 1 97 2 0

1 0 0 442524 4704 21740 0 0 0 0 18203 22 0 97 3 0

2 0 0 442268 4704 21740 0 0 0 0 45101 29 1 99 0 0

Update: Het een en ander liep nogal uit, maar vanaf een uur of 19:00 zou alles weer moeten werken, zo niet, jullie weten ons vast wel te vinden

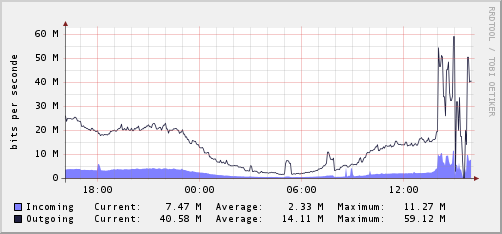

![]() Serverstatus (5 minuten vertraagd)

Serverstatus (5 minuten vertraagd)