De upgrades van het afgelopen weekend waren niet alleen de grootste in de historie van Tweakers.net, maar mogen ook bijgeschreven worden als de langst durende. Vanaf vrijdagavond 19:00u zijn we bijna 15 uur bezig geweest om alle geplande werkzaamheden gedaan te krijgen. Naast de eerder aangekondigde upgrades hebben we ook ons complete rack vervangen door een ander exemplaar met een grotere diepte. Dit was nodig om plaatst te kunnen bieden aan de twee One4Net loadbalancers. Dankzij het nieuwe rack kunnen de loadbalancers nu netjes in sliders opgehangen worden. Het af- en opbouwen van het rack nam echter wel erg veel tijd in beslag. Dit was de voornaamste reden dat de werkzaamheden zo lang duurden.

Gelukkig ging er bij het upgraden van de servers weinig fout. De grootste problemen ontstonden toen de RAID set van Alicia gemigreerd moest worden van de oude situatie met drie schijven verdeeld over twee channels naar de nieuwe situatie met alle schijven op één kanaal. De Adaptec 3200S van Apollo deed dit automatisch, maar bij Alicia waren we genoodzaakt om de RAID set opnieuw aan te maken en een backup terug te zetten. Verder was het zoals gezegd een enorme klus om alle spullen uit het oude rack te trekken en vervolgens samen met de sliders en bekabeling in het nieuwe rack te plaatsen. Het resultaat mag er gelukkig wel wezen. Bijna alle servers hangen nu in sliders terwijl dat voorheen niet het geval was. Apollo en Alicia zijn eindelijk in rackmounts behuisd die een database server waardig zijn. De kabelspaghetti aan de achterkant van het rack, ontstaan door een combinatie van haastwerk en tussentijdse veranderingen, is weggewerkt. De verbeteringen stellen in ons in staat om toekomstige serverupgrades sneller en met minder downtime uit te voeren.

![]() Foto's

Foto's

Uiteraard hebben we weer een camera TeleCity binnen gesmokkeld, zodat de upgrade uitgebreid in beeld vastgelegd kon worden. ISDN- en modemgebruikers moeten zich voorbereiden op een download van rond de 2,5MB ![]() .

.

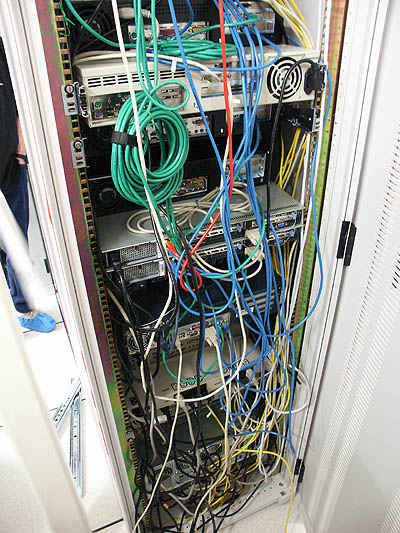

De opstelling van het rack voor de upgrade

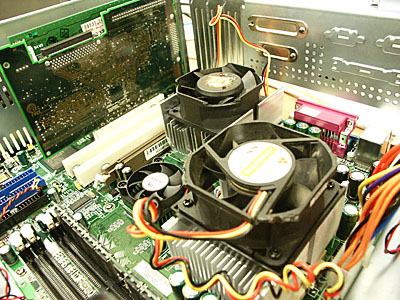

Kees is CPU's aan het hotpluggen onder Windows 2000

Athena's nieuwe Athlon XP 2000+

Athena 3.0

Artemis gaat open voor de plaatsing van twee extra Cheetah X15's

Tweakend Nederland kijkt mee op de webcam

...en ziet hoe het rack wordt leeg geroofd

De colo-vloer lag bezaaid met servers en kabels

Nog meer spullen om het hoekje

"Krijg jij mijn kast dan wil ik jouw proc"

Voorraad Intel Pro/100 NICs

Afgedankt MSI moederbord

Draagbare IRC terminal

Argus showt z'n nieuwe Athlon MP CPU's

Trouwe IBM oostblok SCSI schijf na tweeënhalf jaar nog steeds van de partij

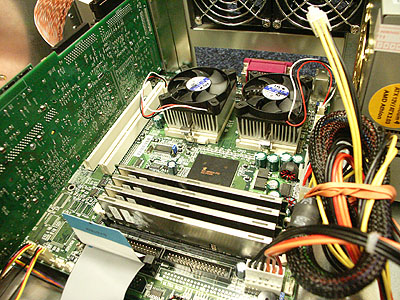

De Supermicro 370DLE begint aan zijn derde leven, nu als mobo van Alicia

Eindelijk Lebensraum voor de MegaRAID

De LVD kabeling achter de SCA hotswap bays van de CI Design rackmounts

Cheetah 36LP in SCA hotswap bay

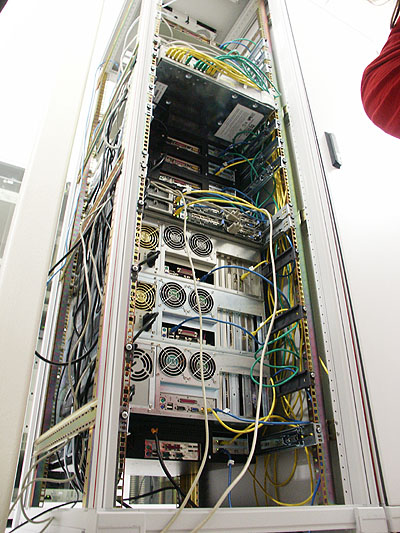

Het nieuwe rack op zijn plaats gezet

De sliders voor de database servers worden op maat gemaakt

Alicia, Apollo, Artemis en Achelois terug in het rack

Half op weg

De 3Com Superstacks en APC Masterswitches in ruimtebesparende opstelling

Het netwerk en de database servers draaien weer!

De 3Com knippert er weer vrolijk op los

Zwart bij zwart, blank bij blank

De twee One4Net B100 loadbalancers in 1U IBM eServer behuizing

Het nieuwe aangezicht van onze servertoren. Van onderen naar boven Achelois, Artemis, Apollo, Alicia, LB1, LB2, Argus, Ares, Arethusa, Adonis, Aphrodite, Athena, Iris en (niet zichtbaar) Styx.

De stroom- en netwerkbekabeling is netjes weggewerkt

In reacties op de vorige .plan kwam naar voren dat er bij sommigen twijfels waren over het nut van de CPU/mobo upgrade van Apollo (dual PIII-1000 / 4GB naar dual Athlon MP 1600+ / 3,5GB). Tijdens de upgrade hebben we besloten om de CPU upgrade van Artemis (Athlon MP 1600+ naar Athlon MP 2000+) achterwege te laten en de Athlon MP 2000+ processors in Apollo te plaatsen. Uit de server statistieken blijkt dat de load en CPU belasting van Apollo met een factor 2,5 is gereduceerd: