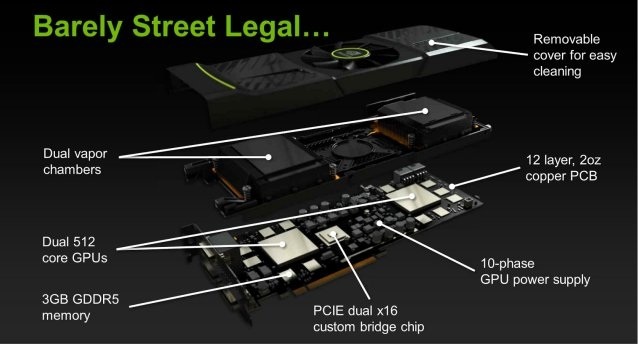

De eerste details van Nvidia's GTX 590 zijn uitgelekt. Het gaat waarschijnlijk om een slide uit een perspresentatie. De slide verklapt de aanwezigheid van twee gpu's met elk 512 Cuda-cores. De koeler bestaat uit twee vapor-chambers en een enkele fan.

De slide laat de verschillende lagen van de videokaart zien, te beginnen met het pcb. Het pcb zou opgebouwd zijn uit twaalf lagen, wat ook voor een high-end videokaart redelijk veel is. Interessanter zijn echter de twee gpu's op het pcb, die elk over 512 Cuda-cores zouden beschikken. Daarmee krijgt de GTX 590 zoals verwacht twee gpu's aan boord zoals die voor de GTX 580 gebruikt worden. De gpu's krijgen hun stroom via een tienfasige voeding, vermoedelijk vier fasen voor elke gpu en een fase voor het geheugen waarover elke gpu beschikt.

De gpu's van de GTX 580, met 512 Cuda-cores, hebben verder een 384bit-geheugenbus. Er is dan ook in totaal 3GB geheugen aanwezig, goed voor 1,5GB per gpu. De twee gpu's staan met elkaar in verbinding via een custom bridge chip, zoals die over het algemeen op dual-gpu-videokaarten van Nvidia zit. De gpu's worden elk gekoeld door een vapor-chamber, terwijl een enkele fan voor de nodige airflow moet zorgen. Hoe effectief die koelmethode is, moet nog blijken. De verwachting is dat de GTX 590 op 22 maart geïntroduceerd wordt.

:strip_icc():strip_exif()/i/1300911674.jpeg?f=fpa_thumb)

/i/1208164214.png?f=fpa)

:strip_exif()/i/1300969843.jpeg?f=fpa)

/i/1237381094.png?f=fpa)

/i/1198048718.png?f=fpa)

/i/1237031931.png?f=fpa)