Intel heeft echter een voordeel: het schrijft ook compilers en daar is het heel goed in. Zo goed dat geen enkele andere x86-compiler in de buurt kan komen van die van Intel.

Dat is niet mijn ervaring. Ik merk dat Visual Studio.NET 2005 vaak betere code genereert dan de Intel C/C++ compiler. Het lijkt erop dat de 'standaard'-code beter door MS gedaan wordt. Intel heeft waarschijnlijk wel meer foefjes voor SSE, HT etc, maar dat is maar beperkt toepasbaar. Mijn code is meestal sneller met de MS-compiler (en mijn code heeft toch vaak veel floating-point berekeningen, recursie, en andere dingen waar een goede compiler zich op zou kunnen uitleven).

Een Itanium kan namelijk tot drie instructies parallel uitvoeren die tot dezelfde instructiestroom horen!

Zoals al opgemerkt zijn dat er dus 6, niet 3.

Een bundle bevat maximaal 3 instructies, en de Itanium heeft 2 pipelines, waardoor je dus 2 bundles, dus 2*3 = 6 instructies tegelijk kunt uitvoeren.

Maar inderdaad, de compiler moet daar het optimalisatie-werk voor doen, want er zitten regels aan wat voor instructies je in een bundle doet... Ze mogen niet afhankelijk zijn etc.

De x86-instructieset werkt heel anders, en daarom zit er dus logica in de processors om de instructies te reorderen. Je kunt vanwege de legacy van x86 er niet vanuit gaan dat de instructies al in een redelijk optimale vorm staan. Bij de bundles van de Itanium weet je al per definitie dat de instructies erin aan bepaalde voorwaarden voldoen, dus is dat een probleem minder voor de CPU, en een probleem meer voor de compiler

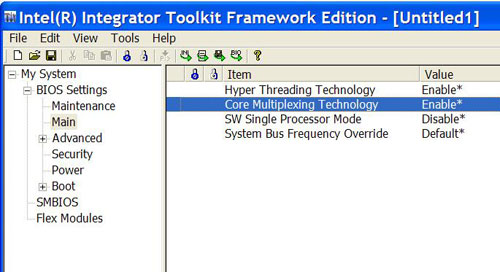

Grote kans dus, dat alle programma's die de laatste jaren zijn geschreven en de Intel compiler gebruiken (Microsoft Visual C en dergelijke maken gebruik van de Intel compiler) al lang geoptimaliseerd zijn voor Core Multiplexing.

Zoals al gezegd, Microsoft heeft dus z'n eigen compiler... Die is ook populairder, omdat ie ten eerste prima prestaties levert, dus de vraag naar de Intel-compiler daardoor niet groot is, en ten tweede omdat je deze compiler toch al bij Visual Studio krijgt, en de Intel-compiler eigenlijk alleen echt bruikbaar is als je hem in Visual Studio integreert, dus de Microsoft-compiler heb je dan toch al gekocht... waardoor het alleen maar duurder wordt om de Intel-compiler te kopen.