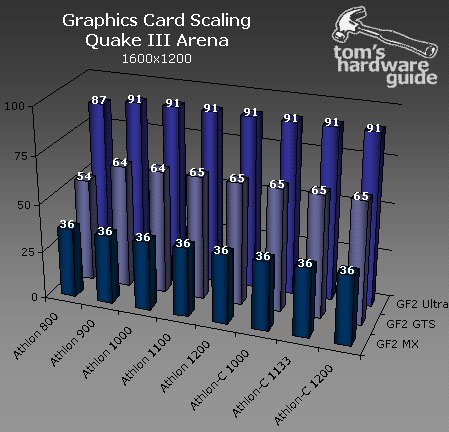

Hoewel de GeForce3 al op de stoep staat vond Tom's Hardware Guide het toch nog even nodig om uitgebreid te testen hoe de hele GeForce2 familie het doet op verschillende processors. De bedoeling van de guide is om mensen te helpen bij de keuze tussen een snellere videokaart of een snellere processor. Veel bedrijven verkopen namelijk PC's door met GHz'en te schreeuwen en vergeten er bij te vertellen dat er slechts een TNT2 videokaart in het 'ultra-moderne multimedia-monster' zit ![]() . Na een groot aantal benchmarks komt men tot de conclusie dat je daar zeker niet in moet trappen en dat een extra investering in de videokaart veel meer winst in spellen oplevert dan een GHz+ processor:

. Na een groot aantal benchmarks komt men tot de conclusie dat je daar zeker niet in moet trappen en dat een extra investering in de videokaart veel meer winst in spellen oplevert dan een GHz+ processor:

I hope that this article underlined precisely that processor clock is not the Holy Grail at all. Many discounters are still selling high-end systems, based on AMD and Intel CPUs beyond 1 GHz, in combination with antiquated graphics cards like a NVIDIA TNT2/Ultra or Vanta, which is definitely the wrong way to keep costs down - even though high processor speeds may sound very attractive.

[...] My outlook for power users is as follows: With a reasonable amount of RAM, the Windows performance is no matter of discussion anyway. Thus the 3D performance becomes the important factor. If your system should be too slow for certain 3D applications, just replace the graphics card with a faster model instead of throwing away the whole system. As of late, new-generation 3D-chips offer significantly larger performance gains than new microprocessors.

|