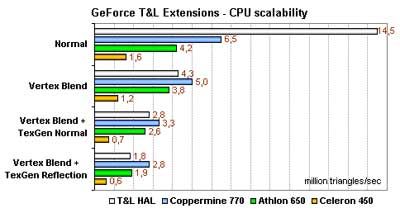

Reactor Critical heeft een aantal pagina's vol geschreven over Transform & Lighting. Na eerst uit de doeken te hebben gedaan hoe TnL werkt hebben ze wat leuke benchmarks gemaakt: deze laten zien dat de maximale TnL snelheid in de meeste gevallen op een GeForce kaart hoger is dan op een Pentium III of Athlon ![]() :

:

The first that leaps to the eye is the obvious dragging of Celeron. The intensive optimization of Direct3D Software T&L Engine for the SSE not only gives Pentium III a clear advantage over Celeron, but also makes it on some occasions faster than the hardware T&L. The same applies to Athlon.

[...] Nevertheless, the example of GeForce shows that the T&L chip running at the frequency of 120 MHz won't run a poor second to the all purpose processors having the frequency close to 1 GHz. Considering the rate at which graphic chips develop, one can safely say that if not the next generation of T&L units comprised by GeForce 2 GTS and Radeon 256 chips, then the one after it will surely outperform all purpose processors in their capabilities. The processors will no longer be quick enough to perform even an ordinary vertex transform in order to load videocards with data. And then the extensions of the geometry pipeline will become a must for game developers.