Inleiding

Met de introductie van de Radeon HD 4890 is de aloude concurrentiestrijd tussen AMD en Nvidia weer een nieuwe fase ingegaan. AMD wilde met de HD 4890 tegenwicht aan de GTX260 bieden, maar op zijn beurt introduceerde Nvidia vrijwel tegelijkertijd de GTX275. Hiermee zijn er voor kopers van high-end-videokaarten weer nieuwe mogelijkheden ontstaan. In deze test zet Tweakers.net de drie kaarten op een rijtje: welke kaart biedt de koper het meest wat betreft prijs en prestatie?

De kaarten zijn niet alleen op hun standaardsnelheden en -spanningen getest. Na het afronden van de eerste serie benchmarks is nagegaan in hoeverre er extra winst te behalen valt uit het opvoeren van de gpu-, de shader- en de geheugenkloksnelheden. Bij de Asus HD 4890 is hiertoe het met de kaart meegeleverde programma SmartDoctor gebruikt. Hiermee is ook bekeken welke winst het manipuleren van de spanning mogelijk nog op kan leveren. Bij de GTX260 van Asus en de GTX275 van Point of View zijn alleen de kloksnelheden aangepast.

Grafieken & Benchmark-database

In deze review worden er nieuwe grafieken gebruikt, waarmee in eerste instantie de gemiddelde resultaten worden weergegeven en besproken. In de tweede grafiek zijn de minimale framerates van de verschillende videokaarten tegen elkaar afgezet. De vetgedrukte lijnen staan voor de standaard geklokte videokaarten, terwijl de transparante lijnen voor de overgeklokte videokaarten staan. Er wordt vastgehouden aan één kleurenpatroon, waarbij de HD 4890 rood is, de GTX275 groen en de GTX260 blauw.

De grafieken zijn gemaakt aan de hand van de benchmarkdatabase. Die is wat betreft videokaarten misschien wat in de vergetelheid geraakt, maar alle geteste videokaarten zullen vanaf nu in de database worden opgenomen. Op die manier kunnen videokaarten gemakkelijk met elkaar vergeleken kunnen worden, ongeacht hoe oud ze zijn. Let wel: de videokaarten worden getest met de nieuwste drivers die op dat moment beschikbaar zijn. Andere, recentere drivers kunnen andere resultaten opleveren.

Specificaties

De GTX260 van Nvidia heeft een bijzondere geschiedenis. De kaart is gebouwd rond de GT200-gpu, die oorspronkelijk op 65nm werd uitgebracht en toen met 576 vierkante millimeter Nvidia's grootste chip ooit was. Toentertijd had de gpu ook nog slechts 192 shaders. De huidige GTX260-gpu's, met de codenaam GT200b, worden op 55nm geproduceerd en beschikken over 216 shaders. Nvidia schakelde een extra shaderblok op de gpu in, opdat de GTX260 de strijd aankon met AMD's HD 4870 beter aan zou kunnen. Na deze aanpassingen bleken de HD4870 1GB en de GTX260 ongeveer even snel.

Met de HD 4890 wilde Advanced Micro Devices een videokaart uitbrengen die de GTX260 te snel af zou zijn. Het aantal shaders van de HD 4890 bleef weliswaar steken op 800 - evenveel als bij de HD 4870 - maar de kloksnelheden van de gpu en het geheugen gingen wel omhoog.

Nvidia reageerde hier weer op door de GTX275 uit te brengen, die met een totaal van 240 shaders 24 extra shaders aan boord heeft ten opzichte van de GTX260. Door de inschakeling van een extra shaderblok zijn er ook acht texture-eenheden extra aanwezig. Ook de kloksnelheden gingen iets omhoog, maar de geheugenbus bleef 448bit. De die size en het aantal transistors bleven onveranderd op respectievellijk 487 vierkante millimeter en 1400 miljoen.

| | HD 4890 | HD 4870 | GTX260 | GTX275 |

| Gpu |

RV790 XT |

RV770 XT |

GT200b |

GT200b |

| Productieprocedé |

55nm |

55nm |

55nm |

55nm |

| Gpu-snelheid |

850MHz |

750MHz |

576MHz |

633MHz |

| Geheugensnelheid |

3900MHz |

3600MHz |

1998MHz |

2268MHz |

| Geheugentype |

gddr5 |

gddr5 |

gddr3 |

gddr3 |

| Geheugen-interface |

256bit |

256bit |

448bit |

448bit |

| Streamprocessors |

800 |

800 |

216 |

240 |

| Rops |

16 |

16 |

28 |

28 |

| Texture-eenheden |

40 |

40 |

72

|

80 |

| Tdp |

190W |

160W |

182W |

216W |

| Chipoppervlak |

256mm2 |

256mm2 |

487mm2 |

487mm2 |

| Transistors |

956M |

959M |

1400M |

1400M |

Point of View Geforce GTX275

|

| Merk |

Point of View |

| Type |

Geforce GTX275

|

| Technische specificaties | |

| Videochip |

GT200b |

| Videochipklok |

633MHz |

| Aantal shaders |

240

|

| Shaderklok |

1404MHz |

| Geheugengrootte |

896MB |

| Geheugentype |

gddr3 |

| Geheugenklok |

1134MHz |

| Productieprocedé |

55nm |

| Interfaces | |

| Card-interface |

pci-e 2.0 16x |

| Verbinding (video uit) |

2x dvi, s-video

|

| Koeling |

actieve koeling |

Asus Geforce GTX260

|

| Merk |

Asus |

| Type |

Geforce GTX260

|

| Technische specificaties | |

| Videochip |

GT200b |

| Videochipklok |

576MHz |

| Aantal shaders |

240

|

| Shaderklok |

1242MHz |

| Geheugengrootte |

896MB |

| Geheugentype |

gddr3 |

| Geheugenklok |

999MHz |

| Productieprocedé |

55nm |

| Interfaces | |

| Card-interface |

pci-e 2.0 16x |

| Verbinding (video uit) |

2x dvi, s-video

|

| Koeling |

actieve koeling |

| Asus Radeon HD 4890 |

| Merk |

Asus |

| Type |

HD 4890 |

| Technische specificaties | |

| Videochip |

RV790 XT |

| Videochipklok |

850MHz |

Aantal streamprocessors

|

800 |

| Geheugengrootte |

1GB |

| Geheugentype |

gddr5 |

| Geheugenklok |

975MHz |

| Productieprocedé |

55nm |

| Interfaces | |

| Card-interface |

pci-e 2.0 16x |

| Verbinding (video uit) |

2x dvi, hdmi |

| Koeling |

actieve koeling |

Testopstelling

Het testsysteem is opgetrokken rond een Core i7 920-processor, die op 3,2GHz is geklokt, met een verhoging van de bclk tot 160MHz. De keuze voor het besturingssysteem viel op de 64bit-versie van Windows Vista Ultimate met Service Pack 1 en alle beschikbare patches geïnstalleerd. De ATI-kaarten worden via versie 9.3 van de Catalyst-drivers aangestuurd. Voor de benchmarks zijn de games Call of Duty: World at War, Crysis: Warhead, Far Cry 2, Stalker: Clear Sky en World in Conflict uitgezocht. Ook van deze games zijn, voor zover beschikbaar, alle patches geïnstalleerd. Indien mogelijk is van de interne benchmarks van de games gebruikgemaakt.

| Testsysteem |

| Moederbord |

Gigabyte GA-EX58-DS4 |

| Processor |

Intel Core i7 920 @ 3,2GHz |

| Geheugen |

6GB ddr3: 3x OCZ3X1333LV6GK 8-8-8 |

| Harde schijven |

500GB Samsung Spinpoint F1 HD502IJ |

| Videokaarten |

Asus Radeon HD4890 1GB

Point of View Geforce GTX275 896MB

Asus Geforce GTX260 Matrix |

| Koeler |

OCZ Gladiator

|

| Voeding |

OCZ Silencer 750EPS12V |

Intels X58-platform zal naar verwachting nog geruime tijd de prestatiekroon in handen houden. Dit platform zal bij het uitvoeren van de benchmarks niet snel een bottleneck vormen. Ook biedt het platform de mogelijkheid om videokaarten zowel in sli- als in CrossFire-modus te draaien. We streven ernaar om altijd de nieuwste drivers te gebruiken, en als er bèta-drivers gebruikt zijn, wordt dat vermeld.

Elke game is getest op de resoluties 1280x1024 1680x1050 en 1920x1200. De instellingen verschillen per game en zullen daarom telkens vermeld worden. In principe wordt altijd anti-aliasing toegepast, tenzij dit resulteert in onspeelbaar lage framerates. Hetzelfde geldt voor sommige ingame-settings, die naar beneden zijn bijgesteld als de videokaart onvoldoende fps wist te produceren. Wel is er altijd 16xAF toegepast; bij games die dat niet ondersteunen is deze instelling afgedwongen met behulp van ATI's CCC of Nvidia's Control Panel.

Overklokken en instellingen

Het overklokken van de videokaarten zal apart besproken worden. Wat betreft de instellingen is in CCC de adaptive aliasing op de hoogste kwaliteit gezet, wordt de toepassing van AA/AF aan de applicatie overgelaten, en is mipmapping op de hoogste kwaliteit ingesteld. Indien nodig wordt, in CCC, 16xAF geforceerd. In Nvidia's Control Panel staat de anti-aliasing transparancy-modus op multisampling en is de texture quality op high quality ingesteld. Ook hier wordt AA/AF aan de applicatie overgelaten en indien nodig wordt 16xAF geforceerd.

DirectX 10.1 en CUDA/PhysX

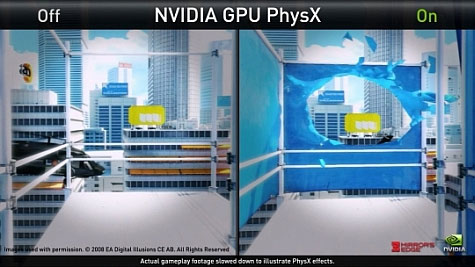

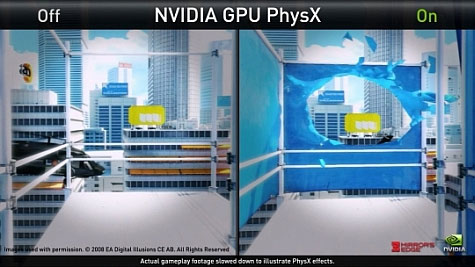

Behalve wat betreft hun prestaties verschillen de videokaarten van Nvidia en AMD op nog andere belangrijke punten. De kaarten van AMD's HD 4800-serie kunnen overweg met DirectX 10.1, terwijl Nvidia al vergevorderd is met zijn gpgpu-technologie genaamd CUDA, en dan met name met PhysX, dat door CUDA op de gpu versneld kan worden.

Op dit moment zijn de spellen die van DirectX 10.1 gebruikmaken nog op twee handen te tellen, maar in die games levert de api wel een aardige prestatiewinst op. Hoeveel spellen met DirectX 10.1-ondersteuning er nog zullen uitkomen is niet duidelijk, aangezien de introductie van de DirectX 11-api nabij is, net als de introductie van videokaarten die DirectX 11 ondersteunen. Het is goed mogelijk dat spellen die gebruikmaken van DirectX 11, ook sneller draaien op DirectX 10.1-kaarten. Ontwikkelaars weten namelijk dat als ze nu met DirectX 10.1 programmeren, toekomstige DirectX 11-kaarten van zowel Nvidia als AMD daarvan kunnen profiteren.

De op handen zijnde introductie van DirectX 11, die uiteraard ook over alle functionaliteit van de voorgaande DirectX-versies beschikt, mag dan een nadeel zijn voor AMD, ook voor Nvidia heeft het implicaties. Op dit moment is er namelijk nog slechts één spel waar Nvidia's PhysX echt een verschil maakt: Mirror's Edge. In andere spellen gaat het voornamelijk om wat minder belangrijke zaken, zoals realistischer watergedrag en het rondvliegen van blaadjes. Met DirectX 11 wordt de gpgpu-applicatie OpenCL geïntroduceerd, waarmee havok-physics versneld kunnen worden, op zowel videokaarten van AMD als van Nvidia. Naast PhysX biedt CUDA ook andere mogelijkheden die AMD ontbeert, maar echte mainstream-applicaties die van CUDA gebruikmaken om de gpu in te zetten zijn er nog niet.

Onze mening is dan ook dat de toegevoegde waarde van zowel CUDA/PhysX als van DirectX 10.1 in de praktijk beperkt is, en niet de doorslag moet geven bij het bepalen van de winnende kaart. Voor de individuele consument kan het interessant zijn om naar de mogelijkheden van Nvidia's CUDA te kijken, maar ook naar de spellen waarin DirectX 10.1 een wezenlijk verschil maakt.

Overklokken

Dat overklokken een duidelijke prestatiewinst op kan leveren staat als een paal boven water, maar het blijft riskant. Zo bleek een van de GTX275-kaarten niet ongeschonden uit de strijd te komen: we zagen zwarte schermen, hoorden knettergeluiden alsof we popcorn maakten en roken zelfs een enkele maal een brandlucht. Point of View reageerde echter adequaat en stuurde prompt twee nieuwe GTX275's op, die allebei zonder kuren de rigoreuze tests wisten te doorstaan.

De GTX275 was al flink door de mangel gehaald toen hij sneuvelde; die kan dan ook als een op zichzelf staand geval gezien worden. Opvallend was overigens de coil whine die tijdens enkele benchmarks optrad. Tijdens een van die benchmarks hield de coil whine dan ook abrupt op, waarna de videokaart de geest gaf. Omdat dit met slechts één kaart gebeurde, kan niet worden gesteld dat het overlijden van de GTX275 gerelateerd is aan de coil whine, maar de andere twee GTX275's van Point of View produceerden geen vervelende hoge tonen.

Asus Voltage Tweak

De HD 4890 werd met behulp van Asus SmartDoctor overgeklokt, omdat met deze applicatie niet alleen de kloksnelheden, maar ook spanning kunnen worden aangepast. De HD 4890 van Asus is voorlopig de enige HD 4890 waarvan de spanning zonder veel moeite verhoogd kan worden, aangezien alleen Asus dergelijke software meelevert. De vraag rest natuurlijk of het verhogen van de spanning ten koste gaat van de levensduur van de videokaart, en of Asus de garantie honoreert mocht een overgeklokte kaart kapot gaan.

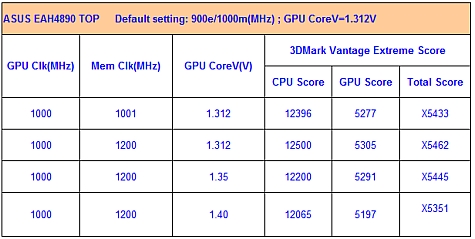

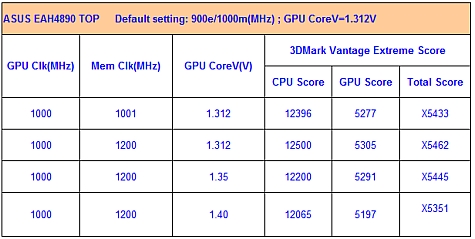

In een gesprek met Baker Chung en David Tung van Asus werd duidelijk dat de maximale spanning van 1,45V binnen de specificaties van AMD valt. Zolang alleen Asus SmartDoctor gebruikt wordt, en de bios niet met een andere bios dan een van Asus geflashed wordt, vervalt de garantie niet. In hetzelfde gesprek werd ook duidelijk dat het simpelweg verhogen van de spanning niet de beste methode is om de videokaart over te klokken. Dit is het eenvoudigst uit te leggen aan de hand van onderstaande tabel, die uit het testlab van Asus komt.

Wanneer bij dezelfde kloksnelheid de spanning wordt opgehoogd, nemen de prestaties van de gpu af, zoals de tabel laat zien. Het is dus zaak om bij de gebruikte overklok naar de laagste spanning te zoeken waarbij de kaart nog stabiel is: een overklok met een spanning van 1,35V en snelheden van 990/1100MHz kan hogere prestaties opleveren dan een overklok met een spanning van 1,4V en snelheden van 1000/1100MHz. De beveiliging van de gpu zorgt ervoor dat de gpu zichzelf vertraagt als er te veel van de gpu wordt gevraagd en er een hogere spanning op de gpu staat. De kloksnelheden zelf worden niet aangepast, dus er is een ander mechanisme in werking, waar Baker echter verder niets over kon vertellen.

Behaalde kloksnelheden

Na wat gestuntel met de HD 4890 werd er genoegen genomen met een overklok van 975MHz en 1100MHz voor respectievelijk de gpu en het geheugen. Een lagere spanning zou theoretisch misschien mogelijk zijn geweest, maar het is noodzakelijk dat de videokaart onder alle omstandigheden volledig stabiel is. Jammer genoeg was een gpu-klok van 1000MHz niet haalbaar, zelfs niet met een voltage van 1,45V. Het geheugen werd rond de 1125MHz instabiel, waarna er voor een veilige 1100MHz is gekozen. Opvallend genoeg moesten de drivers na elke mislukte poging opnieuw geïnstalleerd worden. De reden hiervoor is ons niet duidelijk geworden, maar lastig was het wel.

Net zoals de HD 4890 liet Asus de GTX260 ook niet helemaal met rust. De kloksnelheden mogen dan ingesteld staan op de standaardwaarden van 576MHz, 1242MHz en 999MHz, volgens Asus kunnen die eenvoudig verhoogd worden naar 700MHz, 1500MHz en 1150MHz. Om de stabiliteit te garanderen neemt de spanning daarbij automatisch toe van 1,15V naar 1,18V. In 2d-modus wordt de spanning juist verder verlaagd dan gebruikelijk, waardoor de kaart minder energie verbruikt. De geadverteerde kloksnelheden bleken stabiel; die zijn dan ook in de benchmarks gebruikt.

De nieuwe GTX275 die we van Point of View ontvingen was een standaard geklokte uitvoering. We verhoogden de snelheden zonder moeite naar 700MHz, 1500MHz en 1150MHz, identiek aan de overgeklokte kloksnelheden van de GTX260. Hierdoor kan er een vergelijking gemaakt worden, waarbij alleen het aantal shaders en de bijbehorende tmu's van de twee kaarten verschillen. Relatief gezien is de overklok aanzienlijk lager, maar 700MHz was dan ook zeker niet het maximum.

Far Cry 2

De grafiek spreekt boekdelen. De GTX260 en de HD 4890 zijn aan elkaar gewaagd, terwijl de GTX275 een duidelijke voorsprong op beide videokaarten heeft. Door de HD 4890 over te klokken komt deze in de buurt van de GTX275, maar zodra de GTX275 wordt overgeklokt laat hij de AMD-kaart zijn hielen zien. Let wel, vergeleken met de HD 4890 en de GTX260 werd de GTX275 slechts licht overgeklokt. Als de GTX275 procentueel een even hoge overklok had gekregen, was het verschil nog groter geweest.

De minimale framerates laten eenzelfde verhaal zien als de gemiddelde framerates. Dit maal komt de overgeklokte GTX260 echter wel heel dicht bij de GTX275, ondanks dat de GTX275 over 24 extra shaders beschikt.

Stalker: Clear Sky

Op 1280x1024 onderpresteert de HD 4890 om onverklaarbare redenen. Op de overige twee resoluties presteert de HD 4890 wel iets beter dan de GTX260. De GTX275 is een klasse apart: de kaart zet flink hogere gemiddelde framerates neer. Alleen op de allerhoogste resolutie lijkt de overgeklokte HD 4890 de overgeklokte GTX275 te kunnen evenaren.

De HD 4890 maakt overigens gebruik van DirectX 10.1, wat niet zozeer zorgt voor een verschil in beeldjes per seconde, maar wel voor mooiere graphics. In de toekomst zal geprobeerd worden om dit aan de hand van screenshots aan te tonen.

Wat betreft minimale framerates moet de HD 4890 ook ditmaal zijn meerdere erkennen in de GTX260. Overklokken lijkt erg nuttig: met iets lagere settings kan dat net het verschil maken tussen minimale framerates van rond de 30 of lager.

World in Conflict

World in Conflict laat eenzelfde verhaal zien als voorgaande spellen. De GTX260 en HD 4890 blijken aan elkaar gewaagd, terwijl de GTX275 beduidend sneller is dan deze beide kaarten.

In de CrossFireX-review werd al opgemerkt dat World in Conflict erg vreemde minimale framerates laat zien, waardoor er niet heel veel waarde aan gehecht kan worden. Wel moet opgemerkt worden dat de HD 4890 zeer stabiele resultaten wist neer te zetten, terwijl de Nvidia-kaarten veel wisselvalliger waren.

Crysis: Warhead

De Crysis: Warhead review laat meer van hetzelfde zien. De grafiek is duidelijk en kan maar op één manier geïnterpreteerd worden: de GTX260 en de HD 4890 geven elkaar haast niets toe en de GTX275 staat op een trede hoger.

De minimale framerates zijn wat moeilijker te interpreteren. De overgeklokte HD 4890 presteert hetzelfde als de standaard geklokte HD 4890. De GTX260 daarentegen produceert wel consistent hogere framerates wanneer deze overgeklokt wordt.

Call of Duty: World at War

Call of Duty: World at War laat een ander beeld zien. De videokaarten van Nvidia domineren in dit spel, wat in de CrossfireX-review ook al werd waargenomen. Zelfs de GTX260 is beduidend sneller dan de HD 4890.

De minimale framerates liegen er ook niet om, sterker nog, de minimale framerates van de GTX275 komen akelig dicht in de buurt van de gemiddelde framerates van de HD 4890's. Wel lieten de Nvidia-kaarten meer uitschieters omlaag zien, terwijl de testresultaten van de HD 4890 zeer consistent waren.

Energieverbruik en geluidsproductie

Geluid

Alle drie de videokaarten werden onderworpen aan een geluids- en een verbruiktest. Er is gekeken naar het verbruik en de geluidsproductie terwijl allleen de desktop werd weergegeven, waarbij de videokaart dus in 2d-modus stond. Vervolgens werden de videokaarten met behulp van Furmark maximaal belast. Dezelfde tests zijn nog een keer herhaald, maar dan met de verhoogde kloksnelheden.

Testresultaten van de overgeklokte HD 4890 ontbreken, omdat er met een spanning van 1,4V niet met Furmark getest kon worden. Navraag bij Asus leverde interessante informatie op. De Volterra 1165 M-chipset zou een limiet voor de stroomsterkte hebben, en die limiet wordt in Furmark waarschijnlijk bereikt met een gpu-spanning van 1,4V. Een hogere spanning zorgt altijd voor een crash in Furmark, dus een onstabiele overklok is onwaarschijnlijk.

| Geluidsproductie (dBA) |

| HD 4890 - idle |

45,4 45,4 |

| HD 4890 - load |

59,8 59,8 |

| GTX275 - idle |

46,4 46,4 |

| GTX275 - load |

57,1 57,1 |

| GTX260 - idle |

49,1 49,1 |

| GTX260 - load |

53,1 53,1 |

De GTX260 van Asus heeft een speciaal ontworpen koeler, die volgens Asus stiller zou moeten zijn dan de standaard koeler. Helaas werkte de software van Asus niet naar behoren en ook zonder de software bleven de ventilatoren stug doordraaien op een te hoge snelheid. De gpu was, met een temperatuur van zo'n 30 graden Celsius, erg koel, maar het geluidsnviveau was er ook naar. Wanneer de gpu belast wordt, blikt de speciale koeler wel erg effectief: de gpu werd niet warmer dan 64 graden, terwijl de GTX275 met gemak 85 graden Celsius aantikte. De HD 4890 valt op door in 2d-modus erg stil te zijn, maar bij de minste temperatuurverhoging gaat de ventilator al harder draaien. Bij volledige belasting is de HD 4890 de luidste van het stel.

Energieverbruik zonder overklok

De GTX260, de HD 4890 en de GTX275 hebben achtereenvolgens een tdp van 182W, 190W en 216W. De testresultaten laten dat verschil min of meer duidelijk zien. De HD 4890 valt op door zijn hoge verbruik in 2d-modus, terwijl de GTX275 iets meer verbruikt onder belasting. De Asus GTX260 zou eigenlijk minder moeten verbruiken in 2d-modus, maar aangezien de software niet goed werkte was het niet mogelijk profielen in te schakelen om het verbruik te verlagen. Tijdens het benchmarken zijn de verschillen nog iets groter: de GTX260, HD 4890 en GTX275 namen respectievelijk 305W, 335W en 360W op.

Opgenomen vermogen (W)

|

| HD 4890 - idle |

174 174 |

| HD 4890 - load |

359 359 |

| GTX275 - idle |

147 147 |

| GTX275 - load |

372 372 |

| GTX260 - idle |

150 150 |

| GTX260 - load |

315 315 |

Energieverbruik met overklok

Zoals al toegelicht ontbreken hier de resultaten van de HD 4890. Met enige voorzichtigheid kan wel opgemerkt worden dat de overgeklokte HD 4890 tijdens het benchmarken iets meer energie verbruikte dan de niet overgeklokte HD 4890. Dat ligt voor de hand, en hetzelfde effect valt waar te nemen bij de GTX260 en de GTX275. Overigens neemt het verbruik van de GTX260 wel sterker toe dan dat van de GTX275.

| Opgenomen vermogen (W) |

| GTX275 - idle |

147 147 |

| GTX275 - load |

387 387 |

| GTX260 - idle |

150 150 |

| GTX260 - load |

346 346 |

Ook de snelheid waarop de ventilatoren moeten draaien om de videokaart koel te houden neemt bij het overklokken toe, al is het verschil slechts marginaal. De overgeklokte GTX275 is als enige hoorbaar luider wanneer hij wordt belast. Zowel met als zonder overklok piekte de temperatuur van de GTX275 op 85 graden Celsius, wat doet vermoeden dat de koeler zijn best doet om de kaart niet warmer dan die temperatuur te laten worden.

| Geluidsproductie (dBA) |

| GTX275 - idle |

46,4 46,4 |

| GTX275 - load |

59,3 59,3 |

| GTX260 - idle |

49,3 49,3 |

| GTX260 - load |

53,8 53,8 |

Conclusie

Wanneer het gaat om de prestaties, dan is het niet moeilijk een winnaar aan te wijzen: dat is overduidelijk de GTX275. De HD 4890 is marginaal sneller dan de GTX260, terwijl de GTX275 beduidend sneller is dan deze beide.

De volgende vraag is dan hoe de prijs/prestatie-verhouding voor de kaarten ligt. De goedkoopste GTX275 die op dit moment in de Pricewatch is te vinden, kost 221,95 euro, terwijl de HD 4890 bij de goedkoopste aanbieder voor 204,00 euro weg mag. Het prijsverschil van iets meer dan 15 euro is makkelijk te rechtvaardigen door de duidelijk betere prestaties van de Nvidia-kaart. De GTX275 mag dan onder load iets meer verbruiken, in de 2d-modus, waarin veel computers toch de meeste tijd doorbrengen, verbruikt de videokaart aanzienlijk minder stroom dan de AMD-kaart. Wat betreft de geluidsproductie ontlopen de videokaarten elkaar niet veel.

De geteste GTX260 is eigenlijk een klasse apart. Helemaal representatief is de videokaart niet voor de GTX260 in het algemeen, omdat bij de Asus-kaart tijdens het overklokken de spanning licht verhoogd kan worden. Met een prijs van 201,68 euro is de kaart een prima concurrent voor de GTX275. Uit de benchmarks blijkt dat de overgeklokte GTX260 de GTX275 altijd voor blijft. De GTX275 kan hoger worden overgeklokt dan in deze review is gedaan, maar het verschil zal niet heel groot zijn. De GTX260 van Asus beschikt echter ook over een speciale koeler, die vooral onder load een stuk stiller is.

Heeft AMD met de HD 4890 de plank nu volledig misgeslagen? Die conclusie zou voorbarig zijn. De meer prijsbewuste consument doet er waarschijnlijk verstandig aan om voor ongeveer 150 euro een HD 4870 of GTX260 te kopen, maar in de hogere prijsklasse weet de HD 4890 zich aardig te weren. Dat lijkt misschien in strijd met de getoonde testresultaten, maar om twee redenen komen de Nvidia-kaarten wat geflatteerd uit de tests naar voren. De eerste reden is dat de gebruikte spellen door de bank genomen in het voordeel van Nvidia zijn. De tweede heeft te maken met de gebruikte drivers. Voor de HD 4890 is versie 9.3 van de drivers gebruikt, terwijl versie 9.4-drivers hoogstwaarschijnlijk voor betere prestaties hadden gezorgd. Bij Nvidia werd juist van gloednieuwe bètadrivers gebruik gemaakt, die in drie van de geteste spellen ook een flinke performance-boost zouden moeten geven.

:fill(black)/i/1240479625.jpg?f=thumb)

:fill(black)/i/1240479626.jpg?f=thumb)

:fill(black)/i/1240479627.jpg?f=thumb)

:fill(black)/i/1240479628.jpg?f=thumb)

:fill(black)/i/1240479629.jpg?f=thumb)

:fill(white)/i/1237407722.jpeg?f=thumb)

:fill(black)/i/1240479435.jpg?f=thumb)

:fill(black)/i/1240479436.jpg?f=thumb)

:fill(black)/i/1240479437.jpg?f=thumb)

:fill(black)/i/1240479438.jpg?f=thumb)

:fill(black)/i/1240479439.jpg?f=thumb)

:fill(black)/i/1240479440.jpg?f=thumb)

:fill(black)/i/1240479441.jpg?f=thumb)

:fill(black)/i/1240479442.jpg?f=thumb)

:fill(black)/i/1238682913.jpg?f=thumb)

:fill(black)/i/1238682914.jpg?f=thumb)

:fill(black)/i/1238682915.jpg?f=thumb)

:fill(black)/i/1238682916.jpg?f=thumb)

:fill(black)/i/1238682917.jpg?f=thumb)

:fill(black)/i/1238682918.jpg?f=thumb)

:fill(black)/i/1240479625.jpg?f=thumb)

:fill(black)/i/1240479626.jpg?f=thumb)

:fill(black)/i/1240479627.jpg?f=thumb)

:fill(black)/i/1240479628.jpg?f=thumb)

:fill(black)/i/1240479629.jpg?f=thumb)

:fill(white)/i/1237407722.jpeg?f=thumb)

:fill(black)/i/1240479435.jpg?f=thumb)

:fill(black)/i/1240479436.jpg?f=thumb)

:fill(black)/i/1240479437.jpg?f=thumb)

:fill(black)/i/1240479438.jpg?f=thumb)

:fill(black)/i/1240479439.jpg?f=thumb)

:fill(black)/i/1240479440.jpg?f=thumb)

:fill(black)/i/1240479441.jpg?f=thumb)

:fill(black)/i/1240479442.jpg?f=thumb)

:fill(black)/i/1238682913.jpg?f=thumb)

:fill(black)/i/1238682914.jpg?f=thumb)

:fill(black)/i/1238682915.jpg?f=thumb)

:fill(black)/i/1238682916.jpg?f=thumb)

:fill(black)/i/1238682917.jpg?f=thumb)

:fill(black)/i/1238682918.jpg?f=thumb)

:fill(white):strip_exif()/i/1238579312.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1237471088.jpeg?f=thumbmedium)

/i/1249739662.png?f=fpa_thumb)

/i/1246797829.png?f=fpa_thumb)

/i/1242134496.png?f=fpa_thumb)

:strip_icc():strip_exif()/i/1240002783.jpeg?f=fpa_thumb)

:fill(white):strip_exif()/i/1240314842.jpeg?f=thumbmedium)

:strip_icc():strip_exif()/i/1238686233.jpeg?f=fpa_thumb)

/i/1242232170.png?f=fpa)

/i/1241511581.png?f=fpa)