Inleiding

Inleiding

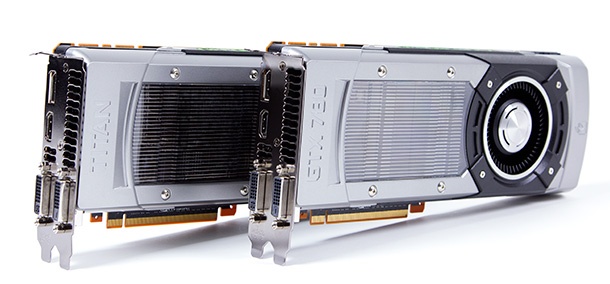

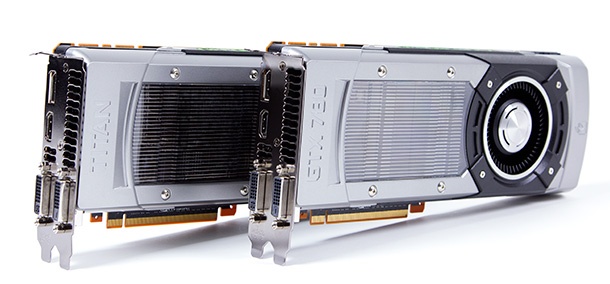

In februari introduceerde Nvidia een nieuwe monsterkaart: de GTX Titan. De kaart heeft een enorme rekencapaciteit en moest korte metten maken met de concurrentie. Dat bleek hij inderdaad te doen. In onze benchmarks moesten we de resolutie naar 5760x1080 pixels opschroeven om de Titan op zijn knieën te krijgen en een minimale framerate te laten zien die lager is dan 30fps. Mooi werk van de fabrikant, maar met een prijs van minstens 900 euro was de videokaart voorbehouden aan de happy few. Wilde je bij Nvidia voor een iets eenvoudiger model gaan, dan was de GTX 680 de eerstvolgende videokaart, die de helft kost, maar wel al sinds maart 2012 meedraait. Met de GTX 780 heeft Nvidia het gat opgevuld en een opvolger voor de GTX 680 in de schappen gezet.

Het gpu-ontwerp van de GTX 780 is geleend van de GTX Titan, die weer gebaseerd is op de Tesla K20-videokaarten. Daardoor krijgt de GTX 780 dezelfde monsterlijk grote gpu, met meer dan 7 miljard transistors mee. De Kepler-gpu heeft vijftien smx-units aan boord, waarvan er drie uitgeschakeld zijn. Iedere smx-unit bestaat uit 192 cuda-cores, waardoor het totale aantal cores op 2304 uitkomt.

| | GTX Titan | GTX 780 | GTX 680 |

|---|

| Gpu |

GK110 |

GK110 |

GK104 |

| Productieprocédé |

28nm |

28nm |

28nm |

| Cuda-cores |

2688 |

2304 |

1536 |

| Baseclock |

837MHz |

863MHz |

1006MHz |

| Boost-clock |

876MHz |

900MHz |

1058MHz |

| Geheugengrootte |

6GB gddr5 |

3GB gddr5 |

2GB gddr5 |

| Geheugensnelheid |

6000MHz |

6000MHz |

6000MHz |

| Geheugenbus |

384bit |

384bit |

256bit |

| Tdp |

250W |

250W |

195W |

Zoals vermeld heeft Nvidia de GTX 780 net onder de Titan gepositioneerd en moet de kaart de GTX 680, die al meer dan een jaar meegaat, opvolgen. Op papier is het in ieder geval een waardige opvolger; de GTX 780 heeft anderhalf keer zo veel cuda-cores als zijn voorganger en eveneens anderhalf keer zo veel geheugen. Om dat geheugen nog wat beter toegankelijk te maken heeft Nvidia de geheugenbus verbreed tot 384 bit. Ten opzichte van de GTX Titan heeft Nvidia de cores van de GK110-gpu ietsje hoger geklokt; de base-clock is 863MHz en de boost-clock komt op 900MHz uit.

Benchmarks en testsysteem

Het belangrijkste aan de GTX 780 zijn natuurlijk de prestaties die in games worden neergezet. Daartoe hebben we de gebruikelijke benchmarks gedraaid en gekozen voor een resolutie van 2560x1440 pixels. Uiteraard vergelijken we de GTX 780 met de Titan om te zien hoeveel verschil 384 cuda-cores en 3GB geheugen maken. Voorganger GTX 680 wordt ook in de benchmarkresultaten meegenomen, net als AMD's snelste single-gpu-kaart; de HD 7970GHz Edition. Meer ter illustratie zijn de resultaten van de GTX 690 en de HD 7990. Deze kaarten vormen geen echt vergelijkingsmateriaal, omdat ze over twee gpu's beschikken.

Testsysteem

Het testsysteem bevat Intels Sandy Bridge E-cpu, gecombineerd met de X79-chipset. Van Intel kregen we een Core i7 3960X-cpu, die in een Asus Rampage IV Extreme-moederbord wordt gestoken. Deze cpu wordt naar 4,3GHz overgeklokt en met de standaardwaterkoeler van Intel op temperatuur gehouden. Verder gebruiken we 8GB op 1600MHz geklokt ddr3-geheugen, een Kingston Sandforce 2281-ssd van 240GB en een Corsair AX750W Gold-voeding. Alle hardware wordt op een benchtable van CoolerMaster gemonteerd.

| Testsysteem | |

|---|

| Moederbord |

Asus RoG Rampage IV Extreme |

| Processor |

Intel Core i7 3960X |

| Geheugen |

Kingston KHX1600C9D3K4/8GX |

| Ssd |

Kingston HyperX 240GB |

| Koeler |

Intel Thermal Solution RTS2011LC |

| Voeding |

Corsair Professional Gold AX750 |

Als benchmarks kiezen we de games Battlefield 3, Alien vs. Predator, DiRT: Showdown, Sleeping Dogs, The Witcher 2, Shogun 2: Total War, Crysis 3 en Far Cry 3. Van deze games worden, voor zover beschikbaar, alle patches geïnstalleerd. Waar mogelijk worden de interne benchmarks van de games gebruikt. Voor alle benchmarks gebruiken we Nvidia's 320.18.

:fill(black)/i/1285675715.jpeg?f=thumb) Elke game wordt getest met een Dell U2711-beeldscherm op de resolutie 2560x1440 pixels. De instellingen verschillen per game en worden daarom telkens vermeld. In principe wordt altijd anti-aliasing toegepast, tenzij dit resulteert in onspeelbaar lage framerates. Hetzelfde geldt voor sommige in-game-instellingen, die naar beneden worden bijgesteld als de videokaart anders onvoldoende fps produceert. Ook passen we altijd 16x af toe. Bij games die dat niet ondersteunen wordt deze instelling afgedwongen met behulp van Nvidia's Control Panel. In Nvidia's Control Panel staat de anti-aliasing-transparancy-modus op multisampling en is de texture quality op 'quality' ingesteld.

Elke game wordt getest met een Dell U2711-beeldscherm op de resolutie 2560x1440 pixels. De instellingen verschillen per game en worden daarom telkens vermeld. In principe wordt altijd anti-aliasing toegepast, tenzij dit resulteert in onspeelbaar lage framerates. Hetzelfde geldt voor sommige in-game-instellingen, die naar beneden worden bijgesteld als de videokaart anders onvoldoende fps produceert. Ook passen we altijd 16x af toe. Bij games die dat niet ondersteunen wordt deze instelling afgedwongen met behulp van Nvidia's Control Panel. In Nvidia's Control Panel staat de anti-aliasing-transparancy-modus op multisampling en is de texture quality op 'quality' ingesteld.

3Dmark en Unigine

We trappen af met 3DMark en Unigine Heaven uit het rijtje benchmarks. Uit de meeste benchmarks blijkt dat de GTX 780 de GTX Titan op de voet volgt. Dat is niet verwonderlijk, omdat het om dezelfde gpu gaat, maar dan met wat minder cores.

In 3DMark verslaat de GTX 780 de snelste single gpu-kaart van AMD met gemak; hij zet een ruim twintig procent hogere score neer dan de HD 7970 GHz. Ten opzichte van voorganger GTX 680 ligt de score zelfs bijna 40 procent hoger. De Titan wordt in deze benchmark goed bijgehouden; de score van de GTX 780 ligt slechts 3,5 procent lager dan die van de GTX Titan. De dual-gpu-kaarten gaan in deze benchmark uiteraard met de prestatiekroon aan de haal.

In Heaven 4.0 blijft de slagorde gehandhaafd, maar is het gat tussen de GTX 780 en de Titan relatief groot, terwijl de HD 7970 GHz dicht in de buurt komt van Nvidia's nieuwste.

Battlefield 3, Crysis 3 en Far Cry 3

Battlefield 3, Crysis 3 en Far Cry 3 hebben we op de hoogste instellingen, met 4x aa en 16x af gedraaid op een resolutie van 2560x1440 pixels. Battlefield 3 is met die instellingen prima speelbaar, maar Crysis 3 en Far Cry 3 zitten hiermee op het randje.

| Battlefield 3 - 2560x1440 - Ultra |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| HD 7990 |

*****

+

**

60,0 / 80,1 |

| EVGA GTX 690 |

*****

+

**

55,0 / 73,5 |

| GTX Titan |

****

+

**

42,6 / 59,9 |

| Nvidia GTX 780 |

****

+

*

44,0 / 57,0 |

| HD 7970 GHz |

***

+

*

32,0 / 43,1 |

| Nvidia GTX 680 |

***

+

*

29,8 / 41,5 |

De minimale framerate van de GTX 780 blijkt met 44fps nog wat hoger te liggen dan die van de GTX Titan. Gemiddeld ligt de framerate, zoals verwacht, weer wat lager.

| Crysis 3 - 2560x1440 - Very High |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| EVGA GTX 690 |

******

+

*

45,3 / 55,0 |

| HD 7990 |

*****

+

*

41,5 / 51,1 |

| GTX Titan |

****

+

*

33,0 / 42,3 |

| Nvidia GTX 780 |

****

+

*

30,0 / 38,0 |

| HD 7970 GHz |

***

+

*

24,5 / 30,9 |

| Nvidia GTX 680 |

***

+

*

24,0 / 28,9 |

In Crysis 3 zit de GTX 780 met een minimale framerate van 30fps op de grens van wat bij de meeste mensen voor speelbaar doorgaat. Zeker tijdens multiplayer-games is het aan te bevelen om de instellingen van Crysis wat omlaag te schroeven.

| Far Cry 3 - 2560x1440 - Ultra |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| EVGA GTX 690 |

******

+

*

48,5 / 56,2 |

| HD 7990 |

*****

+

**

39,0 / 51,9 |

| GTX Titan |

*****

+

*

39,7 / 45,4 |

| Nvidia GTX 780 |

****

+

*

35,0 / 41,0 |

| HD 7970 GHz |

***

+

*

28,0 / 32,6 |

| Nvidia GTX 680 |

***

+

*

27,0 / 30,7 |

Ook in Far Cry 3 heeft de GTX 780 geen verrassingen in petto; de kaart zet opnieuw een score neer die ruim boven die van de HD 7970 GHz en net onder die van de GTX Titan ligt.

DiRT, Shogun en Sleeping Dogs

DiRT Showdown, Shogun 2 en Sleeping Dogs zijn alle drie op ultra-instellingen getest en uit de resultaten blijkt dat de GTX 780 weer geen moeite heeft om speelbare framerates neer te zetten.

| DiRT: Showdown - 2560x1440 - Ultra - 4x aa |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| HD 7990 |

*****

+

**

109,6 / 145,7 |

| EVGA GTX 690 |

****

+

**

92,5 / 121,8 |

| GTX Titan |

****

+

*

90,9 / 110,8 |

| Nvidia GTX 780 |

****

+

*

84,0 / 105,0 |

| HD 7970 GHz |

****

+

*

82,5 / 102,4 |

| Nvidia GTX 680 |

***

+

*

66,6 / 80,8 |

DiRT: Showdown is voor de meeste recente videokaarten een peulenschil. AMD-kaarten presteren over het algemeen wat beter dan Nvidia-kaarten in deze game en dat is te zien aan de HD 7970 GHz, die dicht in de buurt van de GTX 780 komt. Ten opzichte van de GTX 680 presteert de GTX 780 ruim 25 procent beter.

| Shogun 2: Total War - 2560x1440 - Ultra |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| EVGA GTX 690 |

******

+

**

57,0 / 70,5 |

| HD 7990 |

*****

+

**

47,5 / 63,1 |

| GTX Titan |

****

+

*

45,0 / 55,8 |

| Nvidia GTX 780 |

****

+

*

42,0 / 51,0 |

| Nvidia GTX 680 |

***

+

*

30,0 / 38,1 |

| HD 7970 GHz |

**

+

*

20,5 / 30,9 |

In Shogun 2 zijn de Nvidia-kaarten weer in het voordeel. Oudgediende GTX 680 zet hogere scores neer dan de HD 7970 GHz en de GTX 780 gaat daar nog eens overheen. Het verschil met de GTX Titan blijft klein.

| Sleeping Dogs - 2560x1440 - Ultra |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| HD 7990 |

****

+

***

57,4 / 98,4 |

| EVGA GTX 690 |

****

+

**

52,7 / 85,5 |

| GTX Titan |

***

+

**

41,6 / 67,0 |

| Nvidia GTX 780 |

***

+

**

38,0 / 66,0 |

| HD 7970 GHz |

***

+

*

38,2 / 56,0 |

| Nvidia GTX 680 |

**

+

*

31,6 / 48,1 |

Sleeping Dogs is de enige game waarin AMD's HD 7970 een, verwaarloosbaar, hogere minimale framerate kan laten zien dan de GTX 780. De gemiddelde framerate van de 780 ligt 10fps hoger dan die van de concurrent van AMD en is vergelijkbaar met de framerate van de Titan.

AvP en The Witcher

De laatste twee benchmarks zijn Alien vs Predator en The Witcher. Hoewel Alien vs Predator al een tijdje meedraait, blijken recente videokaarten, getuige de minimumframerates, nog een flinke kluif aan de game te hebben.

| Alien vs Predator - 2560x1440 - High - 2x aa |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| HD 7990 |

****

+

***

48,0 / 85,9 |

| EVGA GTX 690 |

****

+

***

48,7 / 82,3 |

| GTX Titan |

***

+

**

40,7 / 64,5 |

| Nvidia GTX 780 |

***

+

**

35,0 / 60,0 |

| HD 7970 GHz |

***

+

**

32,0 / 53,3 |

| Nvidia GTX 680 |

**

+

**

25,5 / 43,6 |

In Alien vs Predator blijft de minimale framerate voor de GTX 780 op 35fps steken, terwijl de kaart er gemiddeld 60fps weet uit te persen.

| The Witcher 2 - 2560x1440 - Ultra |

|---|

| Videokaart | Minimum- / gemiddelde framerate in fps, hoger is beter |

|---|

| EVGA GTX 690 |

*****

+

**

60,5 / 79,0 |

| HD 7990 |

***

+

****

36,0 / 74,8 |

| GTX Titan |

***

+

**

30,0 / 54,4 |

| Nvidia GTX 780 |

***

+

*

40,0 / 53,0 |

| HD 7970 GHz |

**

+

**

26,5 / 42,4 |

| Nvidia GTX 680 |

***

+

*

30,0 / 41,5 |

In The Witcher 2 laat de GTX 780 een uitschieter in de minimale framerate zien, terwijl de gemiddelde framerate wel netjes tussen die van de GTX Titan en de HD 7970 GHz inzit. Waarschijnlijk is hier iets misgegaan, want een 25 procent hogere minimale score dan de GTX Titan is niet aannemelijk.

Conclusie: Nvidia's nieuwe topper

Toen Nvidia de GTX Titan in februari introduceerde, leverde dat wat verwarring op. Was dit de topkaart van de nieuwe 700-serie? Of ging het om een eenmalige actie met een beperkt aantal exemplaren? De prijs van de GTX Titan bleek, afhankelijk van de uitvoering, tussen de 900 en 1100 euro uit te komen. Dat was een ongekend hoog bedrag voor een 'standaard'-videokaart van Nvidia, zonder speciale koeling of overklokmogelijkheden.

Met de GTX 780 schept Nvidia enige duidelijkheid in de line-up; de Titan blijkt inderdaad een extravagant model te zijn, terwijl de 700-serie aangevoerd wordt door een afgeslankte variant van de Titan. 'Daar hoort ook een vriendelijkere prijs bij', moet men bij Nvidia gedacht hebben. Dat resulteerde in een adviesprijs van 650 euro, wat nog steeds een hoop geld is; voorganger GTX 680 kostte bij de introductie 150 euro minder. De GTX 780 is echter wel 250 euro goedkoper dan de GTX Titan en daarmee denken wij dat de 780 meteen de grootste concurrent van de Titan zal worden. Ga maar na: de GTX 780 heeft dezelfde gpu onder de motorkap, minus twee smx-units en drie gigabyte geheugen. Daarnaast heeft de 780 standaard al een iets hogere kloksnelheid en bovendien blijkt uit onze benchmarks dat het verschil tussen de beide videokaarten op een resolutie van 2560x1440 pixels zich nauwelijks laat uitbetalen. Het bijleggen van 250 euro voor een Titan is dan ook alleen zinvol voor gamers die het onderste uit de kan willen, maar geen dual-gpu-videokaart willen aanschaffen. Dat maakt de GTX 780 momenteel een heel interessante videokaart voor gamers met een ruime beurs.

De directe, van AMD afkomstige concurrent van de GTX 780 moet ook nog even genoemd worden in de eeuwige strijd tussen het rode en het groene kamp. De snelste HD 7970, de GHz Edition, staat momenteel al voor 370 euro in de Pricewatch en is daarmee een stuk goedkoper dan de GTX 780. De in januari 2012 geïntroduceerde kaart kan echter niet op tegen het grafische geweld van Nvidia's GTX 780 en blijkt in iedere benchmark het onderspit te delven. Daarmee is de HD 7970 vooral interessant als het budget geen snellere kaart toelaat. We zijn in ieder geval benieuwd naar het eind van 2013, als AMD op Nvidia's nieuwe kaarten moet reageren met de HD 8000-serie. De prestatiekroon onder de single-gpu-videokaarten lag immers met de GTX Titan al bij Nvidia en met de GTX 780 verstevigt de fabrikant zijn grip nog verder.

Pluspunten

-

Op één na snelste single gpu-kaart

-

Prijs ten opzichte van de Titan is gunstig

Minpunten

-

650 euro blijft veel geld voor een videokaart

Eindoordeel

:fill(black)/i/1285675715.jpeg?f=thumb)

:strip_exif()/i/1369207321.jpeg?f=thumblarge)

:fill(white):strip_exif()/i/1369315594.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369315944.jpeg?f=thumbmedium)

/i/1335708372.png?f=fpa)

:strip_exif()/i/1359533752.jpeg?f=fpa)

:strip_icc():strip_exif()/u/423227/crop6272ea0207346_cropped.jpg?f=community)

:fill(white):strip_exif()/i/1374660685.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369314976.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369316722.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369317689.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369384703.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369314606.jpeg?f=thumbmedium)

:strip_exif()/i/1369207321.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1369383507.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1405586957.jpeg?f=thumbmedium)