Inleiding

Bijna twee weken geleden introduceerde ATi officieel de opvolger van de Radeon 9700 Pro, de Radeon 9800 Pro. Dit is een doorontwikkelde versie van de eerstgenoemde en om de prestaties te verhogen heeft ATi niet alleen de kloksnelheden verhoogd, maar ook enkele efficiëntie verhogende features zijn toegevoegd. Hoe de kaart presteert vergeleken met zijn voorganger en de concurrentie, in de vorm van de GeForce FX 5800 Ultra, lees je hier in de review.

De chip

De chip

De belangrijkste verbetering is de kloksnelheid. De Radeon 9800 Pro core is nog steeds gebakken met behulp van het 0,15 micron productieprocédé van TSMC. Om een verhoging van de kloksnelheid mogelijk te maken heeft ATi de chip zodanig aangepast dat de signaalintegriteit en timings verbeterd zijn. Dankzij deze verbetering heeft ATi de kloksnelheid met 17 procent weten te verhogen van 325MHz naar 380MHz. Geen slecht resultaat aangezien de meeste mensen al verrast waren dat ATi in staat was om de 107 miljoen transistors tellende Radeon 9700 Pro op 325MHz te laten lopen.

Ook de snelheid van het geheugen is verhoogd. De Radeon 9800 Pro is uitgerust met een achttal Samsung DDR-chips die standaard werken op 340MHz (680MHz effectief). Hiermee komt de geheugensnelheid 10 procent boven de originele snelheid van 310MHz te liggen. Samen met enkele verbeteringen aan de architectuur moet dit voldoende zijn om een duidelijk verschil tussen de Radeon 9700 Pro en de Radeon 9800 Pro te creëren.

In de nabije toekomst zal ATi de Radeon 9800 familie verder uitbreiden met twee leden. In het tweede kwartaal van 2003 zal de Radeon 9800 het daglicht zien. Deze kaart is identiek aan de Pro-variant met uitzondering van de kloksnelheden die uiteraard lager komen te liggen. Tevens zal ATi een 256MB variant van de Radeon 9800 Pro introduceren. Of de kloksnelheden van deze kaart gelijk of hoger zullen zijn aan die van de 128MB variant is nog niet bekend, maar je zult in ieder geval kunnen rekenen op een stevig prijskaartje.

De kaart

Wij kregen van ATi een testexemplaar van de Radeon 9800 Pro kaart toegestuurd. In de doos vonden we alleen een antistatisch zakje met de kaart, een gebrande cd met drivers en een Molex-kabel. De retail versie zal, zoals we gewend zijn van ATi, completer zijn met de nodige tv-kabels en een DVI naar VGA-verloopstukje.

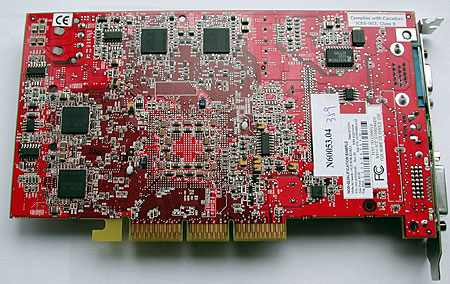

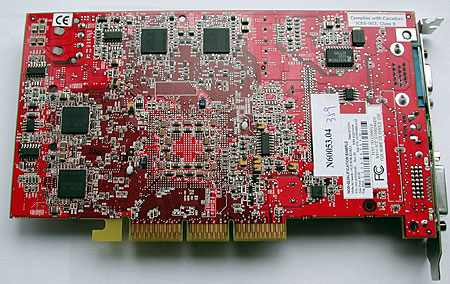

Zoals te zien is op bovenstaande foto's vertoond de kaart grote vergelijkennissen met zijn voorganger, de Radeon 9700 Pro. De layout van beide planken is in grote lijnen hetzelfde, maar een nadere inspectie leert dat de meeste componentjes wel allemaal op een iets andere plek zitten. Evenals bij de Radeon 9700 Pro is de core vlak boven de AGP-aansluiting geplaatst en zijn er een achttal geheugenchips aanwezig verdeeld over de voor- en achterkant van de kaart.

De opvallendste verandering is waarschijnlijk de koeler. In plaats van een zwart geanodiseerde koeler wordt nu een aluminiumkleurig exemplaar gebruikt. Qua formaat lijken de koelers niet veel te verschillen, maar het aantal koelvinnen is bij de Radeon 9800 Pro wel aanzienlijk hoger.

De volgende opvallende wijziging is het plaatsen van kleine heatsinkjes op de transistors die zorgen voor een stabiele stroomtoevoer naar het geheugen en de core. Blijkbaar is het energieverbruik dankzij de hogere kloksnelheden zodanig gestegen dat passieve koeling met een heatsinkje geen overbodige luxe meer is.

De laatste noemenswaardige verandering is die van de stroomvoorziening. Waar de Radeon 9700 Pro een floppydrive aansluiting heeft om gevoed te kunnen worden met bewegende elektronen heeft de Radeon 9800 Pro een harde schijf aansluiting. Technisch gezien is dit geen noodzakelijke veranderding, één floppydrive aansluiting kan meer dan genoeg stroom leveren, maar het is wel een handige verandering. Veel voedingen hebben slechts één floppydrive aansluiting waardoor je de kans loopt dat er geen aansluiting meer vrij is voor de videokaart. Harde schijf aansluitingen zijn er meestal in overvloed en deze hebben tevens het voordeel groter en robuuster te zijn.

Features

De Radeon 9800 Pro core verschilt op een drietal punten met de Radeon 9700 Pro core die ik hieronder één voor één zal bespreken.

Smartshader 2.1

Smartshader 2.1

De eerste verbetering van de Radeon 9800 is te vinden in de Smartshader wat voor ATi reden genoeg was om het versienummer van deze te verhogen van 2.0 naar 2.1. De Radeon 9700 kon maximaal 96 pixel shader instructies verwerken per pass. Meer instructies uitvoeren kan wel, maar daarvoor zijn meerdere passes nodig wat geen gunstige invloed heeft op de snelheid. Dit weet ATi gedeeltelijk te omzeilen met behulp van de zogenaamde F-Buffer:

De F-Buffer voorkomt niet dat er meerdere passes nodig zijn indien er lange pixel shader programma's worden gebruikt, maar verkort de tijd die nodig is voor de extra passes wel aanzienlijk. Doordat de F-Buffer plaats biedt aan de tussenuitkomsten van de berekening hoeft niet de volledige pipeline opnieuw doorlopen te worden bij elke extra pass. Hoewel de techniek leuk klinkt zal het voordeel ervan slechts beperkt zijn. In de naam van compatibiliteit zullen game developers geen shader programma's gebruiken die te lang zijn voor DirectX 9. Het voornaamste toepassingsgebied zal dan ook ergens anders gezocht moeten worden. Professionele 3d-artisten kunnen ze bijvoorbeeld gebruiken om complexe effecten semi-realtime te laten weergeven met plug-ins zoals Renderman.

Smoothvision 2.1

Smoothvision 2.1

De tweede feature waarbij het versienummer met een tiende is verhoogd gaat door het leven onder de naam Smoothvision. Dit is ATi's naam voor de techniek gebruikt voor de anti-aliasing implementatie. De werking van Smoothvision 2.1 is niet werkelijk veranderd ten opzichte van zijn voorloper. Het enige wat ATi heeft gedaan is de geheugen controller optimaliseren om zo het prestatieverlies bij het inschakelen van FSAA te minimaliseren.

Hyper Z III+

Hyper Z III+

Als laatste heeft ATi de verschillende algoritmes die gebruikt worden om zo efficiënt mogelijk om te gaan met de aanwezige bandbreedte geoptimaliseerd. De marketingafdeling van ATi heeft besloten dit aan te duiden met een plusje achter het versienummer. De verbetering van de Hyper Z-algoritmes moet vooral gezocht worden bij de stencil-buffer. Bij de Radeon 9700 Pro was het soms nodig sommige bandbreedte besparende features uit te schakelen zodra bepaalde stencil buffer bewerkingen werden uitgevoerd. De Radeon 9800 Pro kent dit probleem niet meer wat vooral voor betere prestaties zal zorgen in games, zoals Doom 3, die zwaar gebruik maken van de stencil-buffer om realistische schaduwen te tekenen.

De concurrentie

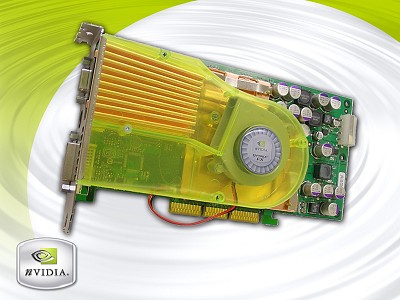

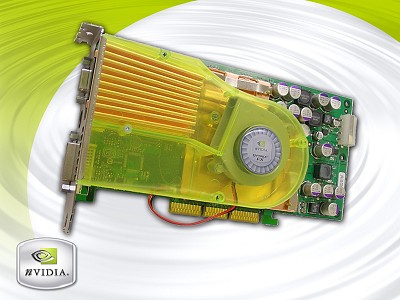

De Radeon 9800-kaart heeft concurrentie in de vorm van nVidia's GeForce FX 5800 Ultra. De GeForce FX werd al vorig jaar in november geïntroduceerd door nVidia, maar de eerste testexemplaren kwamen pas beschikbaar begin 2003 en verwacht wordt dat de kaarten pas volgende maand in groten getale zullen verschijnen in de winkels. Wij kregen van MSI een GeForce FX 5800 Ultra toegestuurd om aan de tand te voelen.

Deze kaart lijkt, afgezien van het merkje, identiek te zijn aan het reference design van nVidia. Aanwezig is de bekende lompe koeler. Hoewel ik geen grote bezwaren heb tegen een grote koeler op de videokaart heb ik wel bezwaren tegen de bijbehorende geluidsproductie. Zolang je bezig bent met 2d-applicaties lopen de core, het geheugen en de koeler op een relatief lage snelheid. Zodra een 3d-programma wordt opgestart worden de snelheden verhoogd en begint de koeler een angstaanjagend geluid te produceren. Alleen tweakers die zich niet ergeren aan een 7000-toeren monster op de processor zullen zich niet kunnen storen aan het geluid. De overige mensen die deze kaart willen kopen raad ik aan om ook te investeren in een setje oordopjes...

Net als de Radeon 9800 Pro wordt de GeForce FX door middel van een molex connector van stroom voorzien. De MSI FX5800 Ultra wordt geleverd in een verpakking van het formaat verhuisdoos en krijgt maar liefst 10 CD's met software en spellen mee (waaronder Ghost Recon, The Elder Scrolls III Morrowind en Duke Nukem Manhattan Project). Verder kun je je kast versieren met een echte MSI Multimedia casebadge

Wat betreft de prestaties ziet de kaart er op papier goed uit. De GeForce FX-chip is opgebouwd uit maar liefst 125 miljoen transistors die op 500MHz lopen. De GeForce FX wordt vergezeld door een achttal GDDR-II chips die effectief op 1GHz lopen. Het datapad tussen de core en het geheugen is echter slechts 128-bit breed, de helft van de breedte van de Radeon 9700 en Radeon 9800. Verder heeft de chip alle broodnodige features om DirectX 9 plaatjes op de beeldbuis te toveren.

Testopstelling

Benchmarks

Unreal Tournament 2003 - 4x FSAA en 8x AF

Unreal Tournament 2003 - 4x FSAA en 8x AF

|

| Unreal Tournament 2003 - dm-antalus - 1024x768 |  |

|

| Radeon 9800 Pro |    130,8 130,8 |  |

|

| Radeon 9700 Pro |    105,5 105,5 |  |

|

| GeForce FX 5800 Ultra |    102,6 102,6 |  |

|

|

| Unreal Tournament 2003 - dm-asbestos - 1024x768 |  |

|

| Radeon 9800 Pro |    183,9 183,9 |  |

|

| GeForce FX 5800 Ultra |    150,7 150,7 |  |

|

| Radeon 9700 Pro |    148,7 148,7 |  |

|

|

| Unreal Tournament 2003 - ctf-citadel - 1024x768 |  |

|

| Radeon 9800 Pro |    112,3 112,3 |  |

|

| Radeon 9700 Pro |    92,7 92,7 |  |

|

| GeForce FX 5800 Ultra |    92,5 92,5 |  |

|

Voor het testen van de performance van de kaarten in Unreal Tournament hebben we naast de demo van het spel ook het UT2003 benchmark utility van HardOCP gebruikt. We hebben gekozen voor de "High Quality"-optie waarna de bovenstaande getallen uit het programma kwamen rollen. Zoals te zien is zijn de verschillen tussen de Radeon 9700 en de GeForce FX ditmaal minimaal. Het verschil is in geen van de testen meer dan enkele frames per seconde en in de laatste test is het verschil zelfs maar 0,2 FPS. Jammer genoeg voor nVidia is de Radeon 9700 niet langer het topproduct van ATi, maar de Radeon 9800. Deze kaart kan zonder problemen de prestaties van de Radeon 9700 en de GeForce FX verbeteren met circa 25 procent.

CodeCreatures - 4x FSAA en 8x AF

CodeCreatures - 4x FSAA en 8x AF

|

| CodeCreatures - 1024x768 |  |

|

| GeForce FX 5800 Ultra |    32,5 32,5 |  |

|

| Radeon 9800 Pro |    29,3 29,3 |  |

|

| Radeon 9700 Pro |    24,2 24,2 |  |

|

De CodeCreatures benchmark is een intensieve DirectX 8.1 test waarbij grote hoeveelheden polygonen gebruikt worden. In deze omstandigheden blijkt de GeForce FX goed te presteren. De kaart is niet alleen aanzienlijk sneller dan de Radeon 9700, maar ook moet de Radeon 9800 in het stofbijten. Met een score van 32,5 FPS is de GeForce FX circa 10 procent sneller dan de Radeon 9800.

Comanche 4 - 4x FSAA en 8x AF

Comanche 4 - 4x FSAA en 8x AF

|

| Comanche 4 -1024x768 |  |

|

| Radeon 9800 Pro |    53,38 53,38 |  |

|

| GeForce FX 5800 Ultra |    50,74 50,74 |  |

|

| Radeon 9700 Pro |    49,10 49,10 |  |

|

De laatste benchmark die de kaarten voor de kiezen kregen was de Comanche 4 benchmark. Dit is wederom een DirectX 8 benchmark, maar ditmaal gebaseerd op een populair vliegspel in plaats van een nog niet op de markt gebrachte 3d-engine. De onderlinge verschillen tussen de kaarten zijn in de benchmark niet groot. De Radeon 9800 wint met een voorsprong van circa 5 procent van de GeForce FX die op zijn beurt weer nipt wint van de Radeon 9700.

Beeldkwaliteit

Conclusie

ATi heeft met de Radeon 9800 Pro een product op de markt gezet waaraan het topmodel van nVidia niet kan tippen. De GeForce FX heeft moeite genoeg op de Radeon 9700 Pro bij te houden en de Radeon 9800 Pro die gemiddeld ruim twintig procent sneller is, is simpelweg teveel voor de GeForce FX.

Een ander belangrijk punt is koeling en de geluidsproductie van de twee kaarten. Waar nVidia een ingewikkelde constructie nodig heeft die één PCI-slot in beslag neemt en een ongeëvenaarde hoeveelheid geluid produceert weet ATi een relatief simpel en stil koelertje te gebruiken. Wellicht is dit nog wel het grootste voordeel van de Radeon 9800 ten opzichte van de GeForce FX. Al loopt een spel perfect, als dat vergezeld moet worden door een stofzuigergeluid word je toch niet blij.

Een ander belangrijk punt is koeling en de geluidsproductie van de twee kaarten. Waar nVidia een ingewikkelde constructie nodig heeft die één PCI-slot in beslag neemt en een ongeëvenaarde hoeveelheid geluid produceert weet ATi een relatief simpel en stil koelertje te gebruiken. Wellicht is dit nog wel het grootste voordeel van de Radeon 9800 ten opzichte van de GeForce FX. Al loopt een spel perfect, als dat vergezeld moet worden door een stofzuigergeluid word je toch niet blij.

Om de overwinning voor ATi helemaal compleet te maken zal de Radeon 9800 Pro hoogstwaarschijnlijk ook nog eens 'vriendelijker' geprijsd worden dan de GeForce FX 5800 Ultra. Helemaal vast staat dit nog niet aangezien beide kaarten slecht tot niet verkrijgbaar zijn op het moment. Hoe dan ook, het moge duidelijk zijn dat ATi op het moment de beste videokaart in huis heeft met de Radeon 9800 Pro. Wellicht dat nVidia het leiderschap weer kan overnemen met de NV35 in het komende kwartaal, maar voorlopig is ATi king of the hill.

![]() De chip

De chip

Een ander belangrijk punt is koeling en de geluidsproductie van de twee kaarten. Waar nVidia een ingewikkelde constructie nodig heeft die één PCI-slot in beslag neemt en een ongeëvenaarde hoeveelheid geluid produceert weet ATi een relatief simpel en stil koelertje te gebruiken. Wellicht is dit nog wel het grootste voordeel van de Radeon 9800 ten opzichte van de GeForce FX. Al loopt een spel perfect, als dat vergezeld moet worden door een stofzuigergeluid word je toch niet blij.

Een ander belangrijk punt is koeling en de geluidsproductie van de twee kaarten. Waar nVidia een ingewikkelde constructie nodig heeft die één PCI-slot in beslag neemt en een ongeëvenaarde hoeveelheid geluid produceert weet ATi een relatief simpel en stil koelertje te gebruiken. Wellicht is dit nog wel het grootste voordeel van de Radeon 9800 ten opzichte van de GeForce FX. Al loopt een spel perfect, als dat vergezeld moet worden door een stofzuigergeluid word je toch niet blij.