Gigabyte Aorus GeForce RTX 3090 Xtreme Waterforce WB 24G review

Getest in combinatie met:

- AMD Ryzen Threadripper 3960x

- 64GB G.Skill 3600MHz CL16 (4x16)

- ASUS Prime TRX40 Pro (UEFI 1402)

- Lian-Li O11 Dynamic XL (40x360mm radiator bodem, 30x360mm radiator top, DDC pomp, single-loop met GPU vóór CPU)

- 2x Samsung 970EVO 500GB (Raid-0), 1x Samsung 970Pro 512GB

- Corsair HX1000i power supply

Introductie

Na reeds een aantal jaar in bezit te zijn geweest van een RTX2080, werd het door een wens voor vooral meer VRAM, nieuwe connectiviteit, en een wens om mijn kast correct te kunnen sluiten tijd voor een nieuwe GPU. Na lang wikken en wegen, viel mijn oog op een RTX3090-gebaseerde kaart en dat is helaas mede door CUDA, en de wens voor >10GB VRAM.

Mijn vorige kaart, een MSI Gaming-X Trio, had ik zelf van een waterblok van EK voorzien (wat eigenlijk nét te breed was voor de O11 dynamic XL door de terminal), en hoewel me dat goed bevalt, was de wens om bij een kaart van >€1500 dit toch eigenlijk af-fabriek te hebben. Gelukkig is dit steeds meer voorkomend, en waterkoelen is gelukkig ook steeds minder een kwestie van “prutsen” en steeds meer van “aansluiten en gaan”.

Mijn PC is altijd “work hard, play hard” geweest qua opzet, en de ‘belofte’ van nVidia dat de RTX 3090 series een “titan replacement” is, is aantrekkelijk. Want naast standaard GeForce stijl zaken, kennen Titans ook zaken die typisch op Quadro’s zitten.

Waarom wil ik hem + ArcGIS Test

Naast gamen, houd ik mij ook bezig met GIS-werkzaamheden die in natuur wat weg hebben van CAD (hoewel minder strict op de driver). Machine Learning is steeds meer een factor, en bij het verwerken van sommige GIS workloads is VRAM de beperkende factor geworden. Dit hoofdzakelijk in pakketten als ArcGIS Pro. Een simpele workflow waar ik mee test is het renderen van een CityJSON dataset “tour” naar een video. De belasting hierbij is volledig VRAM & CUDA, en voert in feite zeer veel render verzoeken uit die allemaal via de GPU gaan.

/m/175440/1L7ksH3hr2ISLi4gKkZM7qowV0BV8SCeK9STI8wNMwcdcR0I09.png?f=620xauto)

De belasting is niet mis. Het renderen van een flink stuk Amersfoort, zelfs met vrij simpele textures en meshes, belast het volle VRAM:

/m/175440/1L7ksH1pgbltxM8V70zJt69MbaYbuPKMypO68FiyBTSLZecwgp.png?f=620xauto)

De performance is echter significant beter dan hoe de RTX2080 presenteerde: de render task was klaar in 50 minuten, tegenover ruim 3u40min voor de RTX2080. De RTX3090, hoe dom het ook klinkt, is daarmee een goede “laad veel GIS data, render het geheel en encode het naar video”-kaart.

Dit is natuurlijk niet het enige waar de kaart gebruikt gaat worden, machine learning is natuurlijk ook een factor, maar ik heb daar geen tests op gedaan. In plaats daarvan refereer ik naar de volgende website:

RTX 3090 Benchmarks for Deep Learning - NVIDIA RTX 3090 vs 2080 Ti vs TITAN RTX vs RTX 6000/8000 - Exxact (exxactcorp.com)

– uit de tests hier blijkt dat de 3090 dubbel de performance bied van een RTX2080Ti, en die was weer sneller dan mijn gewone RTX2080. Hiermee is een ander doel behaald… De RTX3090 is voor mij een goede “titan replacement”. Hier dien ik echter wel een kanttekening te plaatsen:

Veel van de super precision benchmarks tussen de RTX-serie kaarten en Quadro, zeker in software zoals SiemensNX, laten zien dat de RTX kaarten hier significant slechter in presteren. Deze software zit echter niet in mijn scope, en dat maakt de RTX3090 voor mij wenselijk. Zit je echter meer in de BIM, CAD, of flow/physics wereld, dan is een Quadro, of zelfs Tesla “GPU” waarschijnlijk wenselijker… dat zijn echter per uitstek géén gamekaarten…

De verpakking en de hardware

Ondanks twijfelachtige beschikbaarheid kon ik de kaart dankzij wat… handige automatisering die ik niet ga delen… vrij eenvoudig vinden bij Azerty, waar de kaart €2099 kostte op het moment van aanschaf. De kaart werd direct de volgende dag geleverd, in een véél te grote doos:

:strip_exif()/m/175440/1L7ksH2usBlnLRo1CWaORo86pueguEkXND8gCa9QIRx29wfwUq.jpeg?f=620xauto)

(USB Stick for Scale)

Binnen in de doos vinden we:

- De GPU

- Een Aorus badge

- Een Aorus actiefiguurtje

- Een envelop met garantie informatie en een quick-install guide

- Een tube koelpasta die niet nodig is bij installatie.

:strip_exif()/m/175440/1L7ksH1g5wHcPPCN1vjCNRKI3Qu1ZtdsMMoYKvEafD0kTr4WSr.jpeg?f=620xauto)

Dit geheel komt wat karig over, en ook op de productpagina van Gigabyte zelf is weinig te vinden over de kaart zelf. Functionaliteiten als dual BIOS ontbreken, wat de kaart per definitie niet een overklok-droom maken naar mijn mening.

Bovendien zijn er headers op de GPU aanwezig, zoals een “J5011” header die er uit ziet als een soort RGB/fanheader, zonder dat er iets op aangesloten is, of er een pinout op de PCB geprint staat.

:strip_exif()/m/175440/1L7ksHP1bBJSsd5KyN8a9tagLwnRUVn2qV2XtbZrdFt6rrIkEU.jpeg?f=620xauto)

Hoewel de verpakking dus mooi is, is de informatie summier. Dat mag de pret niet drukken, want zelfs in vergelijking met mijn érg degelijke EK waterblock, is dit door Gigabyte zelfontworpen blok prachtig. De kleurstellingen zijn neutraal, de afwerking is ruim voldoende, en naast de kwaliteit van het blok, de backplate, en de kaart, is ook alles in te stellen aan de RGB. Hier moet wel opgemerkt worden dat de RGB zaken bovenop zéér subtiel zijn in vergelijking met de kaart zelf.

Er dient ook opgemerkt te worden dat dit een dual-slot watergekoelde kaart is. Niet alleen vanwege de “dikte” van een RTX3090/de aansluitingen, maar ook vanwege het blok zelf: voor de “lol” in m’n 2e PCIe x16 slot geprobeerd deze kaart te plaatsen, met in het derde slot m’n SSD’s, en het waterblok was gewoon te dik. Waarschijnlijk maar goed ook… want dit is een hongerig beestje, waarover later meer…

De aansluitingen op de kaart zelf zijn ruim voldoende, met maar liefst 3x HDMI 2.1, en 3x DisplayPort. Overigens kunnen volgens de specs ‘maar’ 4 poorten tegelijkertijd gebruikt worden. Gezien mijn ambitie om mijn scherm te upgraden (naar een scherm wat HDMI2.1 gebruikt en OLED is), is het goed dat deze kaart voorbereid is op nieuwe aansluitingen. De DisplayPort aansluitingen zijn voorbereid op DisplayPort 1.4.

De Hardware

Vooraf gesteld moet worden dat door de aard van het beestje, het meten van temperaturen op een watergekoelde kaart erg lastig is: naast variaties in kamertemperatuur, ik heb géén airconditioning om die constant te houden, wordt de water-loop natuurlijk door meerdere hittebronnen gevoed, waaronder een ook niet bepaald zuinige Threadripper, en hoewel een radiator bovenin de kast is geplaatst, is er ook een forse radiator onderin de kast aanwezig die hitte rechtstreeks op de kaart blaast. Bovendien is de TRX40 chipset van het moederbord ook niet bepaald “vriendelijk” (hoewel er 15W op de doos staat is het eerder 20W), en hangt er een drietal SSD’s vlak onder de kaart in een ander PCIe x16 slot. Toch, bij ongeveer 900W aan hitte in het systeem (volgens de voeding zelf, uitgelezen met Corsair Icue, blijft de kaart koel onder belasting:

/m/175440/1L7ksH2eI0RZmljnvXn5Ujik8BjlrqYoNTUMiDTvftJeCZf7eS.png?f=620xauto)

De temperatuur met mijn loop zit na 30min furmark (screenshot vlak na die 30min met heat-soaked loop) genomen zit op 48 graden stabiel:

/m/175440/1L7ksHlcT36PwsSLRF5rY69gjh33gu1aB3FxsF7xUjB8Jp7eiJ.png?f=620xauto)

De kloksnelheden van de GPU lopen in auto-boost op naar 1980MHz, wat voor een RTX3090 érg netjes is. Toch ga ik, mede door de krapte van m’n power supply (had met een CPU overklok aan al een shutdown door PSU overload… sindsdien CPU overclock maar weg), niet proberen om dit naar 2GHz te trekken, of zelfs het geheugen te versnellen: met 9751MHz is dat voorlopig snel genoeg!

Wat wel opvalt is dat de GPU coil whine produceerd onder extreme belasting. Dit valt echter alleen op als de fans van mijn loop minimaal draaien… iets wat ze niet lang doen onder volle belasting…

+ Kleine GPU voor een 3090, past in O11 Dynamic XL

+ Mooie RGB, goede verlichting

+ Robuuste backplate die de bovenkant (waar VRAM zit) ook koelt

+ Erg goed koelblok, mooie afwerking.

+ Handige features zoals power-quality LED’s bij de 8-pin connectors

+ Lek-detectie (hoewel het eigenlijk al te laat is op het moment dat dat afgaat…)

+ Connectiviteit

+ Géén noodzaak tot 3 8-pin connectors…

+ Hoge standaard clocks: overclocker BIOS

- 2x 8pin biedt (150+150, 75 van slot) 375W ruimte… dat is voor deze kaart met overclock bios op het grensje: daisy chain je 8-pin connectors niet!!

- Milde coil whine

- Stroomverbruik

- De zijkanten van het PCB zijn niet meegekleurd… en dat is érg zichtbaar

De software

Een kaart met dusdanig veel RGB-opties gaat helaas, bij het opstarten de eerste keer in regenboog-modus. Hoewel RGB naar mijn mening een methode is om hardware volledig naar smaak in te richten, en van significante meerwaarde kan zijn voor een systeem… is een groot nadeel de beheersbaarheid, en de standaardisatie.

:strip_exif()/m/175440/1L7ksH3ffct3gahJTa4iaQHHXiz5u3tisAWrIfY1tcXZqNLXIc.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH1BXiXgZwwSid4FHfzrYKdpq4XxwGhFgmqzSlSIunAE2B.jpeg?f=620xauto)

Mijn systeem kent momenteel de volgende RGB-ecosystemen:

- Asus (Aura)

- Corsair (iCue)

- Logitech

- Razer (bezig met uitfasering)

- Creative

- Philips Hue

En daar is recent Gigabyte Aorus dus bij gekomen. Hier kan ik echter kort over zijn… RGB Fusion is, van alle systemen, veruit het zwakste. Het geheel is gekoppeld aan AORUS Engine:

/m/175440/1L7ksH1xhNwwwSJ6zwWPHvZwQB6PkmexMSuoRslPPVIu9ZXQ5u.png?f=620xauto)

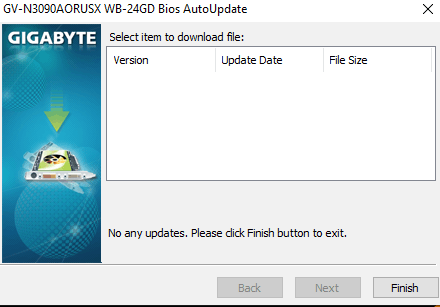

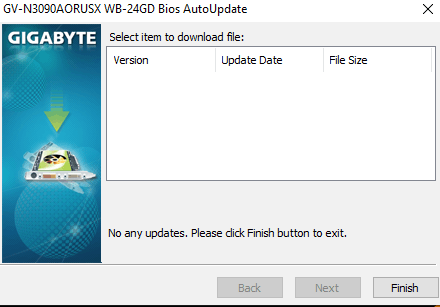

Dit is alles… en ergens ver ver ver in deze applicatie is de enige plek om de GPU z’n BIOS te updaten:

Let op de "No Any Updates"...

Naast uiterlijkheden/een gebrek aan functies (afterburner doet hetzelfde/beter), is er een gebrek aan performance, slechte vertalingen, en constante push meldingen. RGB Fusion pakt bovendien ‘ad-hoc’ andere componenten (m’n RAM…) en beslist dat die van Asus zijn. Er zijn ook functies die gewoon niet werken, zoals een ‘uit’ set definiëren, of LED’s individueel aan te sturen/aan te sturen met een API om bijvoorbeeld “ambilight” te bouwen.

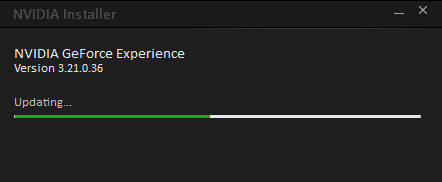

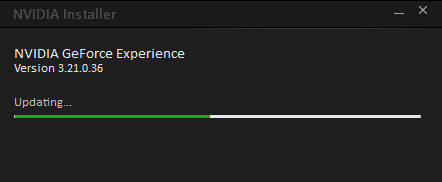

De nVidia drivers zijn ondertussen ook een… geval apart geworden. Niet alleen is er een onderscheid tussen “studio” en “gaming” optimized drivers (wat mijn “master of all” benadering teniet doet…), ook is de nu 633 MB grote driver verdeeld in meerdere applicaties, waar bepaalde functionaliteit (ansel/filters/streaming) achter een inlog systeem verstopt zitten (GeForce Experience). Sinds mijn laatste ervaring daarmee is het wel beter geworden: het systeem vraagt nu tenminste voordat het game-instellingen overschrijft, maar ze maken naar mijn mening nog niet altijd heel veel sense: de suggesties zijn heel erg “nvidia’ minded, en minder gamer-minded. Een goed voorbeeld hiervan is World of Warcraft:

Oh wacht…

/m/175440/1L7ksH3F6MNmJBFil8D2Vqmf2Av7yPZgBl4zjVqQ4NgyJ9rWyF.png?f=620xauto)

Er wordt duidelijk een push gezet op raytracing, terwijl de WoW community er vrij unaniem over is dat dit de kwaliteit benadeeld…

Bovendien bind de overlay (die gelukkig uit kan) aan ALT+Z… een keybind die o.a. in veel applicaties word wrap aan/uit zet… zit je in VSCode python te rammen, en komt er ineens een “HOI IK BEN ANSEL” naar boven…

Als streamen naar een nVidia Shield niet iets is wat je doet, en Ansel/novelty filters niet helemaal je ding zijn… dan zou ik 100% aanraden om GeForce Experience >NIET< te installeren

Dat brengt de driver naar een ander ding, en dat is helaas dat ik in de huidige staat de driver niet snel zal aanraden…

- De known issue lijst met games is fors… variërend van “flickering” tot zaken als video die niet speelt.

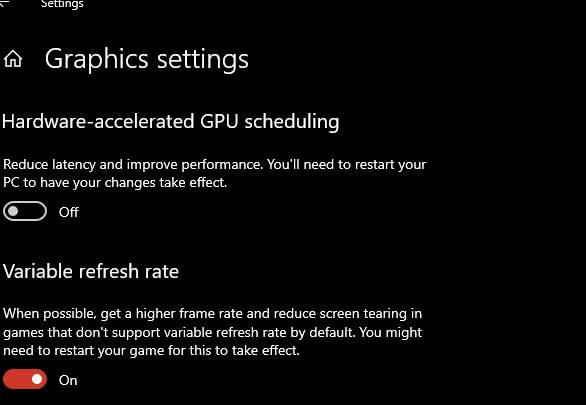

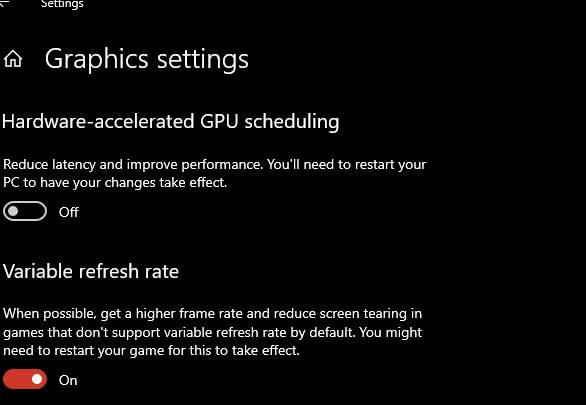

- Gekkigheid met gsync is niet uniek, maar momenteel wel heel systematisch: in bepaalde gevallen kunnen er zelfs situaties ontstaan waar hardware accellerated video “ineens” over je scherm staat.

- Issues met (chromium) based zaken zitten er momenteel ook in, wat uiteindelijk betekend dat je mag zoeken en zoeken totdat je op Reddit een oplossing vindt voor iets obscuurs als: “youtube tankt FPS” in de vorm van het veranderen van de ANGLE backend naar OpenGL IPV Direct3D (verander edge voor chrome als je dit probleem hebt in chrome):

/m/175440/1L7ksH3X26G5mJksvaNKKFbICj5x1oFpDKLYG29AwUbMcSOYmM.png?f=620xauto)

Er is gelukkig verbetering aangekondigd, en ook resizable BAR (wat al in m’n threadripper rig zit) is een belofte die gemaakt is…

Software als nVidia Broadcast is dan eigenlijk ineens geweldig, en geeft goed aan hoeveel potentie wel in de technologie achter deze kaarten zit.

Verder zijn de prestaties ook in games en 3DMark gewoon goed. Zoals gesteld draai ik een GSync 3440*1440 scherm en tsja… de resultaten spreken voor zich:

/m/175440/1L7ksH29W6SJlm9y4yaQSmbFXukmKhdtlF22tB4HbZx7CwSdBf.png?f=620xauto)

Ook een game als Cyberpunk 2077 maxed out (maar zonder DLSS) komt niet beneden de 60fps op 3440*1440, hoewel ik dit niet wetenschappelijk gemeten heb: daar hebben zat andere reviewers meer tijd aan besteed: mijn doel is enkel en alleen het reviewen van de hardware. Voor 1440p (trek het gemiddelde tussen 4k en 1440p voor ultrawide klopt ongeveer) bij CyberPunk, zie dit:

reviews: Cyberpunk 2077 - Next-gen game voor next-gen hardware

Een game als World of Warcraft, zelfs mét RTX, is natuurlijk een stomme test met dit soort GPU’s (en daar koop ik hem niet voor). Zelfs in een druk orebos, of een drukke raid is FPS vrij consistent tussen de 90 en 100 met dynamic spell effects: de GPU is echter nooit een limiet en zit vrolijk rond 24% belasting te “tuffen”: de CPU, ondanks alle moderne multithreading in dergelijke games, is de grens hier. En dat ik aan 90FPS zit, is met een GSync scherm goed te overleven – vooral dankzij het feit dat het een RPG is. Ook in games als Doom kom ik echter keurig aan m’n FPS cap, en “unlocked” komt Doom 2016 Vulkan met gemak rond de 400fps uit…

Conclusie

Dit is een zware dobber… Aan de ene kant is het een hardwarematig mooi product met maar één onvolkomenheid, zijnde een milde coil whine (en dat is mild, hoewel er rapportages zijn van mensen die een bromvlieg-tegen-het-glas hebben gekocht aan coil whine…). Het waterblok is prachtig, doet zijn werk goed, en de GPU is snel, en standaard érg goed schalend qua overklok.

De software is wat minder. De nVidia drivers zijn op zijn zachts gezegd slecht. Naast stabiliteit/grove bugs, zijn ze groot, log, en gedeeltelijk achter een login verstopt. Mocht je zeggen: GPU=GPU, Driver = Driver, dan kan je zonder dat geheel, en zelfs nVidia control panel voegt steeds minder toe, nu zelfs Windows een slider heeft voor VRR (=Gsync):

De bugs in de driver, en de eigenaardigheid rondom de “reddit-fixes” die momenteel nodig zijn, geven helaas toch een bijsmaak: de “WAF”-factor van deze kaarten zijn laag.

En dat is dan eigenlijk alleen nVidia… Gigabyte maakt het nog bonter:

- Afwezigheid van documentatie

- BIOS update functie verstopt in niet-kritische applicatie die wel enorm intrusief is om te moeten installeren: BIOS + Flash tool staat niet op de Gigabyte-site

- Slecht werkende RGB software die bovendien stoort met andere RGB software. Letterlijk… het ding voelt alsof het door Google Translate geschreven is, terwijl er een combo is van diverse knop-stijlen waar sommigen er uit zien alsof ze met een slechte crop-tool in MS-paint transparant zijn gemaakt...

Ik wou dat Gigabyte hun software en documentatie op het niveau van de hardware bracht… of API’s open zouden zetten, zodat projecten als OpenRGB de GPU kunnen verlichten.

Er is dus een behoorlijke lijst pluspunten, en minpunten. Voor €2000 mag dat ook. Ik begon dit artikel met een reflectie op deze kaart voor mijn werkzaamheden. Daar is hij goed voor, hoewel ik ook dáár een kunstmatige beperking van de kaart aangaf op het niveau waar de Quadro kaart op speelt… Is dit dus een “titan-esque” kaart? Ja. Maar niet voor iedereen. En eigenlijk is het met mijn systeem niet meer voldoende om zelfs een 1000W voeding te hebben, en dat maakt dit een gek verhaal… Ik ben er wel blij mee. Zeker als je kijkt hoe compact deze kaart is, en hoe robuust het geheel oogt. Er zitten schoonheidsfoutjes in, en software daar kan wat aan gedaan worden.

Zou ik deze kaart echter aanraden? Nee… en momenteel komt dat juist dóór de software…

:strip_exif()/m/175440/1L7ksH3ffct3gahJTa4iaQHHXiz5u3tisAWrIfY1tcXZqNLXIc.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH425TVrdp5cPNol3sKjlsv3RHolQ6NkiD5ixn9qNlZmD8.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH3apU0uBzYXELPlTmaE8gIyGa6FTQtrQouhMH6e30Rywa.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH2fMLNpQ0bg3PdQ1U6DHf6zymBbTRZpVLBUh0lTOHYope.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH1snCqpgzoxtKY9w50tm4OZyOYgUtnUvC1gdCyLZeLKjU.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH3v6g7YdneluccwQqTDm3oRGj1G5PpTXiIjZU3AGD2OgK.jpeg?f=620xauto)

:fill(white):strip_exif()/i/2004071152.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071152.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071152.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071136.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071138.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071140.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071142.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071144.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071146.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071148.jpeg?f=imagemediumplus)

:fill(white):strip_exif()/i/2004071150.jpeg?f=imagemediumplus)

/m/175440/1L7ksH3hr2ISLi4gKkZM7qowV0BV8SCeK9STI8wNMwcdcR0I09.png?f=620xauto)

/m/175440/1L7ksH1pgbltxM8V70zJt69MbaYbuPKMypO68FiyBTSLZecwgp.png?f=620xauto)

:strip_exif()/m/175440/1L7ksH2usBlnLRo1CWaORo86pueguEkXND8gCa9QIRx29wfwUq.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH1g5wHcPPCN1vjCNRKI3Qu1ZtdsMMoYKvEafD0kTr4WSr.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksHP1bBJSsd5KyN8a9tagLwnRUVn2qV2XtbZrdFt6rrIkEU.jpeg?f=620xauto)

/m/175440/1L7ksH2eI0RZmljnvXn5Ujik8BjlrqYoNTUMiDTvftJeCZf7eS.png?f=620xauto)

/m/175440/1L7ksHlcT36PwsSLRF5rY69gjh33gu1aB3FxsF7xUjB8Jp7eiJ.png?f=620xauto)

:strip_exif()/m/175440/1L7ksH3ffct3gahJTa4iaQHHXiz5u3tisAWrIfY1tcXZqNLXIc.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH1BXiXgZwwSid4FHfzrYKdpq4XxwGhFgmqzSlSIunAE2B.jpeg?f=620xauto)

/m/175440/1L7ksH1xhNwwwSJ6zwWPHvZwQB6PkmexMSuoRslPPVIu9ZXQ5u.png?f=620xauto)

/m/175440/1L7ksH3F6MNmJBFil8D2Vqmf2Av7yPZgBl4zjVqQ4NgyJ9rWyF.png?f=620xauto)

/m/175440/1L7ksH3X26G5mJksvaNKKFbICj5x1oFpDKLYG29AwUbMcSOYmM.png?f=620xauto)

/m/175440/1L7ksH29W6SJlm9y4yaQSmbFXukmKhdtlF22tB4HbZx7CwSdBf.png?f=620xauto)

:strip_exif()/m/175440/1L7ksH3ffct3gahJTa4iaQHHXiz5u3tisAWrIfY1tcXZqNLXIc.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH425TVrdp5cPNol3sKjlsv3RHolQ6NkiD5ixn9qNlZmD8.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH3apU0uBzYXELPlTmaE8gIyGa6FTQtrQouhMH6e30Rywa.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH2fMLNpQ0bg3PdQ1U6DHf6zymBbTRZpVLBUh0lTOHYope.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH1snCqpgzoxtKY9w50tm4OZyOYgUtnUvC1gdCyLZeLKjU.jpeg?f=620xauto)

:strip_exif()/m/175440/1L7ksH3v6g7YdneluccwQqTDm3oRGj1G5PpTXiIjZU3AGD2OgK.jpeg?f=620xauto)