Vanmiddag zullen we in de colo van TrueServer onderhoud plegen aan ons serverpark. Dit zal enige ongemakken met zich meebrengen, met name voor de bezoekers van het forum:

![]() Stabiliteits- en koelingsproblemen

Stabiliteits- en koelingsproblemen

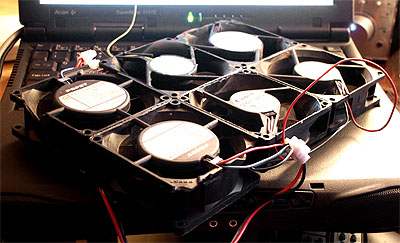

De laatste paar weken hebben we wat stabiliteitsproblemen geconstateerd bij de servers de bovenin het kabinet hangen. De problemen zijn zo erg dat Iris het na een reset veelal niet langer dan een half uur volhoudt. Omdat de temperatuur in ons kabinet al behoorlijk hoog was en zeker niet lager is geworden sinds de plaatsing van twee Strikerz.net) vermoeden we dat oververhitting de oorzaak is van de problemen. De temperatuur sensor van Athena geeft momenteel een CPUtemp van 57 graden aan en dat is dicht tegen de limiet. Het is de bedoeling dat we wat lucht gaan verplaatsen door bovenin het kabinet een koelmuur te modden van zes 8cm fans (waaronder twee nostalgische Papst ventilators uit een Amiga 2000). Voor de geïnteresseerden hieronder een plaatje van dit primitieve bouwsel:

|

NXS Internet heeft spontaan aangeboden een Varicon fan module te sponsoren zodat het bovenstaande bouwwerk weer zo snel mogelijk uit het kabinet verwijderd kan worden ![]() .

.

Tweakers.net draait nu in zijn geheel op Athena, waardoor de site soms wat onaangename momenten kent. De load op Athena is met een gemiddelde Dane-Elec heeft met ons een grote sponsoring deal gesloten waardoor wij alle servers kunnen uitrusten met nieuwe Dane-Elec repen. Morgen worden de single-processor webservers geupgrade naar 1GB RAM (momenteel 512MB). Op een later tijdstip zullen de dual Pentium III database servers worden voorzien van 4GB geheugen. De hiervoor benodigde 1GB DIMMen zijn nog niet in ons bezit. We hebben een Tbird 1333 en een MSI K7T Turbo klaarliggen die gebruikt kan worden om Iris te upgraden als de tijd dit toelaat. De hardware die is overgebleven van de originele Athena configuratie is samengebracht tot een nieuwe server die tijdelijk gaat dienen als web- en database server voor Fok!. Zodoende kan de belasting op Artemis verminderd worden en kunnen een aantal problemen met MySQL replication opgelost worden. Dit zal de snelheid en bereikbaarheid van Tweakers.net verbeteren. De server beschikt over een 1,2GHz Tbird processor, (tijdelijk) 1,5GB RAM, een Maxtor 7200RPM IDE schijf van 20G en twee 7200rpm IBM SCSI schijven. Er wordt momenteel gewerkt aan de bouw van een derde database server die de beschikking zal hebben over een volwaardige configuratie met SCSI RAID, 4GB RAM en twee PIII's. Deze server zal onder andere de databases van Fok! gaan draaien. Artemis wordt binnenkort geupgrade naar dual Athlon MP 1600+ met een Tyan Thunder K7 moederplank en 2GB Dane-Elec DDR SDRAM. De CPU's werden wederom ter beschikking gesteld door AMD.![]() Geheugen upgrades webservers

Geheugen upgrades webservers![]() Plaatsing Fok! web/database server

Plaatsing Fok! web/database server![]() Status

Status