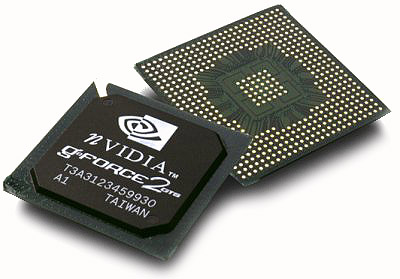

The Inquirer beweert dat nVidia al sinds de GeForce2 een kleine hoeveelheid cache op haar chips meebakt. Een aantal maanden geleden testte een anonieme developer met een GeForce2 hoe snel textures van het videogeheugen naar de chip werden vervoerd, en concludeerde dat er cache aanwezig moest zijn, omdat dit soms veel sneller ging dan theoretisch mogelijk was. nVidia ontkende dit, en beweerde dat er wel wat dingen tijdelijk werden opgeslagen, maar dat dit in totaal niet meer dan 16KB kon zijn, en zeker niet in de vorm van een cache. Verder geëxperimenteer wees echter uit dat er wel degelijk een klein stuk geheugen op de chip zelf moeten zitten, zo rond de 128KB. Sinds de GeForce3 moeten er zelfs twee caches aanwezig zijn:

Nvidia changed its marchitecture in chip in Geforce 3 and 4 that made the earlier test unusable. The engineers suggested, however, that Geforce 3 and 4 were using at least two cache memories inside the GF3s and GF4s rather than just one used in the GF2.

Met dank aan RawPeanut voor de tip.